- +1

AI社會學︱算法的21種“公平”,你要哪一種?

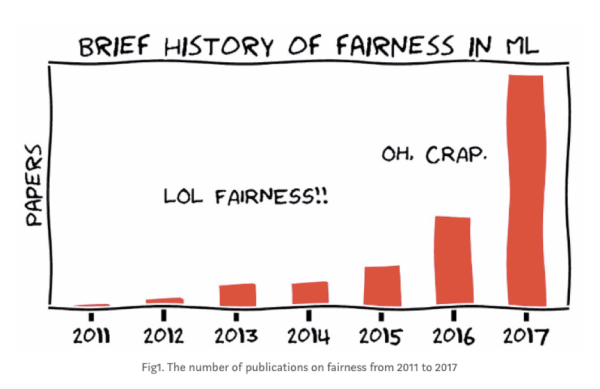

2016年5月,美國著名的非盈利媒體ProPublica發表了一篇題為《機器偏見》(Machine Bias) 的調查性報道。如果之前在人工智能和機器學習領域有關公平 (fairness) 和偏見 (bias) 的議題還只是小范圍的學界爭論,僅在FATML (Fairness, Accountability, and Transparency in Machine Learning) 等新興會議里被討論,這篇報道之后關鍵詞里涉及“公平”的機器學習論文開始呈指數級增長。有普林斯頓計算機系教授阿爾文德?納拉亞南(Arvind Narayanan)精心制作的美圖為證:

在這篇影響力巨大的報道里,ProPublica分析了一個名為COMPAS的機器學習系統。在美國地方的司法體系里,COMPAS被廣泛應用于預測被告的再犯幾率,作為建議量刑的基礎。基于一系列復雜的歷史數據,包括年齡、性別和已有的犯罪記錄,COMPAS預測案件行為人(或被告)被再次逮捕的概率,得出一個1到10分之間的 “危險分” (risk score) 供法官參考:分數越高,行為人被再次逮捕的概率越高,也就越危險。

機器學習的擁躉們認為,比起人類法官們固有的歧視和偏見,利用大數據得出的結論要客觀中立的多。畢竟,數據不會說謊,算法永遠客觀,不是嗎?然而,ProPublica的報道提示了另外一種可能。報告利用公開數據,分析了佛羅里達州布勞沃德縣(Broward County)1.8萬人的COMPAS分數和犯罪記錄,得出了一個驚人的發現:盡管COMPAS的正確預測率達到了61%,在它的系統里,黑人與白人的分數分布卻明顯不同。黑人更有可能被誤判,即被預測為高風險卻沒有再犯,白人則更有可能被漏判,即被預測為低風險卻再次犯罪。不同種族間的誤判 (false positive) 和漏判 (false negative) 率的差距可以高達50%。

有趣的是,故事在這里并沒有結束。在ProPublica報道發布并引起巨大爭議之后,COMPAS的母公司做出了正面回應。它重新在ProPublica的數據上運行了自己的算法,并公布了自己算法在不同種族之間的分布。COMPAS爭論道,他們的系統是“公平”的,而公平依據是,在他們的算法里,無論黑人白人,預測為高風險的被告再次犯罪的概率都是相同的。也就是說,如果你采取的公平定義不是誤判和漏報率,而是高風險的預測正確率 (predictive parity) 的話,COMPAS的算法并無偏見和歧視之說。

接下來,機器學習和統計學領域的大牛們就這個問題展開了精彩的辯論,各種關于公平的數學定義層出不窮,一度達到21種之多。統計學家們很快發現,COMPAS與ProPublica衡量公平的標準存在沖突。他們采用的公平定義都是抵達某一種“公平”的方式,但如果兩個群體之間本身用來訓練模型的數據存在差異(在COMPAS的例子里,黑人的總體再犯率比白人要高),那么在統計上各種“公平”的定義就是不可兼容的。也就是說,算法不可能兼顧ProPublica提出的“公平” 和COMPAS提出的“公平”。即使數學上可能會有完美的“公平”定義,在現實世界的復雜社會關系里,完美且唯一正確的“公平”是不存在的。

納拉亞南在他2018年FATML的教程里戲謔道:現在“公平”這么熱門,如果你想在機器學習的各大會議上灌水,可以想想怎樣再多開發一些復雜的、統計學意義上的“公平”定義。這當然是玩笑話。他想進一步指出的是,光致力于發展統計學上嚴格的“公平”定義可能是徒勞的,不論在數學上有多么嚴謹。因為不僅人類世界不可能有完美的“公平”算法,每一種所謂的“公平”法則背后其實都是復雜的社會關系和政治訴求。

在COMPAS的例子里,案件行為人或被告最關心的可能是誤判 (false positive) ,而城市居民們最關心的可能是漏判 (false negative),兩者是此消彼長的關系,不可能全部滿足。那么,誰的利益應該放在前面?如果必須作出取舍的話,算法里這條取舍的線應該畫在哪里?

1980年,社會學家蘭登?溫納(Langdon Winner)寫下了至今仍然是經典名篇的《技術有政治嗎》(Do artifacts have politics)。其議題在算法統治世界的今天仍然重要,也許比任何時候都更加重要。

當時溫納在科技重鎮麻省理工力排眾議,探討科技產物和社會關系的復雜互動。他認為,科技產物是有政治性的,而過去政治哲學的討論里大大低估了科技的重要性。但這里的“政治性”并非單向度的“科技影響社會”或是“社會影響科技”;科技在與社會的復雜互動里生成,進化,并深刻地嵌入和塑造當時當地的歷史社會和權力關系之中。

溫納舉了1940年代由加州大學研究員在當地開發并推廣的番茄收割機作為其中的一個例子。相比手動收割,機器收割可以大大提高效率。可是,雖然以效率和現代之名推廣,這一新興技術卻并沒有使當地居民平等地享有它的經濟收益。缺少有效的社會反思和合適的政策約束,昂貴的機器雖然提高了生產力和生產效率,卻促進了番茄種植業的工業化和集中化,大大減少了當地小農種植者和手工收割者的工作崗位,致使無數勞動者流離失所。看上去微不足道的小小機器最終以一種令人驚訝的方式徹底重構了當地的社會和經濟關系。

溫納總結到,“the thing we called ‘technologies’ are ways of building order in our world.” 我們所說的“科技”其實是在這個世界上(重新)建立秩序和規則的方式,算法同理:誰受益?誰受損?誰得到更大的權力?誰受到更多的傷害?誰被包含進來?誰又被排除在外?

每年講完COMPAS的案例,都會有學生質疑:你講了那么多,具體來說我們到底該怎么做(what are the actionable items here)?21種不同的公平定義,我們調試模型的時候應該使用哪一種?彼時我在計算機學院浸淫稍久,深知 “actionable items”乃是社會學家和計算機學家的根本分歧,紅海兩分,從此無法對話。社會學家的根本目的常常并不是解決問題,并對一切聲稱能將復雜人類問題簡單化和算法化的路徑持有質疑,而工程師的程序里少了一個括號都無法運行。每當這個時候,我都會面露詭異微笑,祭出計算機大牛辛西婭?德沃克(Cynthia Dwork)在這場“公平大辯論”里的名言:

“Fairness” metric is assumed to be public and open to discussion and continual refinement.

當“公平”本身是社會的和政治的,算法不可能也不會是社會關系的絕緣體。我們能做的第一個“actionable item,”就是把黑箱打開,然后開始問,我們想要的,到底是什么樣的算法“公平”?

【參考文獻】

[1] Angwin, Julia, Jeff Larson, Surya Mattu, and Lauren Kirchner. "Machine bias." ProPublica, May 23 (2016): 2016.

[2] Narayanan, Arvind. "21 definitions of fairness and their politics. (Feb.23, 2018)." In Tutorial presented at the Conference on Fairness, Accountability, and Transparency, vol. 21.

[3] Dieterich, William, Christina Mendoza, and Tim Brennan. "COMPAS risk scales: Demonstrating accuracy equity and predictive parity." Northpointe Inc (2016).

[4] Feller, Avi, Emma Pierson, Sam Corbett-Davies, and Sharad Goel. "A computer program used for bail and sentencing decisions was labeled biased against blacks. It’s actually not that clear." The Washington Post (2016).

[5] Winner, Langdon. "Do artifacts have politics?" Daedalus (1980): 121-136.

[6] Dwork, Cynthia, Moritz Hardt, Toniann Pitassi, Omer Reingold, and Richard Zemel. "Fairness through awareness." In Proceedings of the 3rd innovations in theoretical computer science conference, pp. 214-226. 2012.

-----

作者沈虹,畢業于美國伊利諾伊大學香檳分校傳播學系,現任職于美國卡內基梅隆大學。她用社會學的方法研究新興科技。

- 報料熱線: 021-962866

- 報料郵箱: news@thepaper.cn

互聯網新聞信息服務許可證:31120170006

增值電信業務經營許可證:滬B2-2017116

? 2014-2025 上海東方報業有限公司