- +1

8倍提升表現:谷歌新算法,從多人對話里分清誰在發言

量子位 報道 | 公眾號 QbitAI

不過,可以有新鮮解法啊 (畢竟從前的成績不夠好) 。

谷歌AI團隊說,最近這20年套路都沒變過,就分兩步:

一是檢測聲譜的變化,確定說話人什么時候換了。

二是識別對話里的每個說話人。

他們不想被傳統做法困住,開發了新方法:利用語音識別,把語言學線索和聲學線索搭配食用,幫助區分。

團隊還發現,要有機結合這兩種線索,RNN-Transducer (RNN-T) 是最合適的架構。

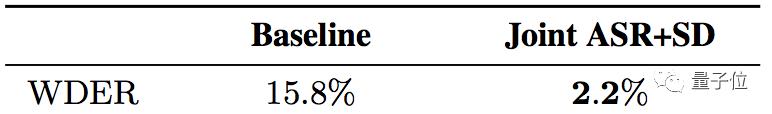

最終結果,谷歌新模型把單詞級的錯誤率 (WDER) ,從15.8%降到了2.2%。且多種錯誤情況皆有明顯改善。

論文還中選了INTERSPEECH 2019。

傳統方法缺陷在哪

谷歌團隊總結了四個主要的局限:

第一,對話先要被拆解成單人片段。不然就沒辦法準確傳達一個說話人的特征。

但事實上,現有的說話人變換檢測方法不完美,會導致拆分出的片段里,還是有多個說話人。

第二,聚類的時候,必須要知道總共有多少個說話人。這個信息如果不準確,就會嚴重影響模型的表現。

第三,系統需要在拆分片段的大小上面,做一個艱難的權衡。

片段越長,嗓音名片的質量就越好,因為每個說話人的信息多了。但風險在于,短暫的插話 (Short Interjections) 容易被判斷錯誤。

這在醫療或金融領域的對話上,都可能產生很嚴重的后果。

患者回答“有 (Yes.) ”,和醫生問“有么 (Yes?) ”,差別是很大的。

第四,傳統方法沒有一個簡單的機制,來利用好語言學線索。

比如,“你用藥多長時間了?”通常是醫生問的,不是患者問的。

所以,這些坑要怎么填呢?

得天獨厚的RNN-T

RNN-T這個架構,原本是在語音識別上大展拳腳。

而團隊發現,它最適合用來把聲學和語言學的線索整合到一起。注意,語音識別和說話人區分,不是暴力結合,是優雅地整合成了一個簡單系統。

RNN-T模型,由三個不同的網絡組成:

二是預測網絡,負責根據前面的目標標簽 (Target Labels) ,預測下個目標標簽。RNN-T能預測的符號 (Symbol) 更豐富,如說話人角色 (Speaker Role) ,如發音 (Pronunciation) 。

三是聯合網絡,把前兩個網絡的輸出結合起來,在輸出標簽的集合上,生成一個當前時間步的概率分布。

劃重點,架構里有一個反饋循環 (Feedback Loop) 。在這里,先前識別出的單詞都會作為輸入,反饋回去。

這樣,RNN-T模型就能利用語言學的線索了:比如一個問句結束,很可能是要換人了。

谷歌說,這個模型可以像訓練語音識別系統那樣訓練:

訓練樣本,是一個人說的話加上一個標簽 (Tag) ,用來定義說話人的角色。比如:

“作業什么時候交?”<學生>

“明天上課之前交。”<老師>

訓練完成,就可以輸入一段語音,得到每個字的分類結果了。

那么,和基線對比一下,來看成果如何。

主角是把語音識別 (Speech Recognition) 和說話人區分 (Speech Diarization) 結合成一個系統,基線是把兩者分開再適配:

說話人在很短的時間里發生變化,單詞邊界 (Word Boundaries) 處的切分,語音重疊造成的數據集說話人標注錯誤,以及音頻質量差的問題。

團隊還補充說,RNN-T系統在各種不同的對話里,平均錯誤率比傳統方法更穩定:方差更小。

傳送門

論文在這里:

https://arxiv.org/abs/1907.05337

博客在這里:

https://ai.googleblog.com/2019/08/joint-speech-recognition-and-speaker.html

— 完 —

本文為澎湃號作者或機構在澎湃新聞上傳并發布,僅代表該作者或機構觀點,不代表澎湃新聞的觀點或立場,澎湃新聞僅提供信息發布平臺。申請澎湃號請用電腦訪問http://renzheng.thepaper.cn。

- 報料熱線: 021-962866

- 報料郵箱: news@thepaper.cn

互聯網新聞信息服務許可證:31120170006

增值電信業務經營許可證:滬B2-2017116

? 2014-2025 上海東方報業有限公司