- +1

2025年GDC|“大模型越普及,AI治理越急迫”

DeepSeek火爆全球,人人都用上了AI,但在專家看來,在這一情況下,如何解決大模型的安全問題和治理問題也變得更為迫切。

“大模型存在誘導和欺騙行為怎么辦?”“大模型失控了怎么辦?”

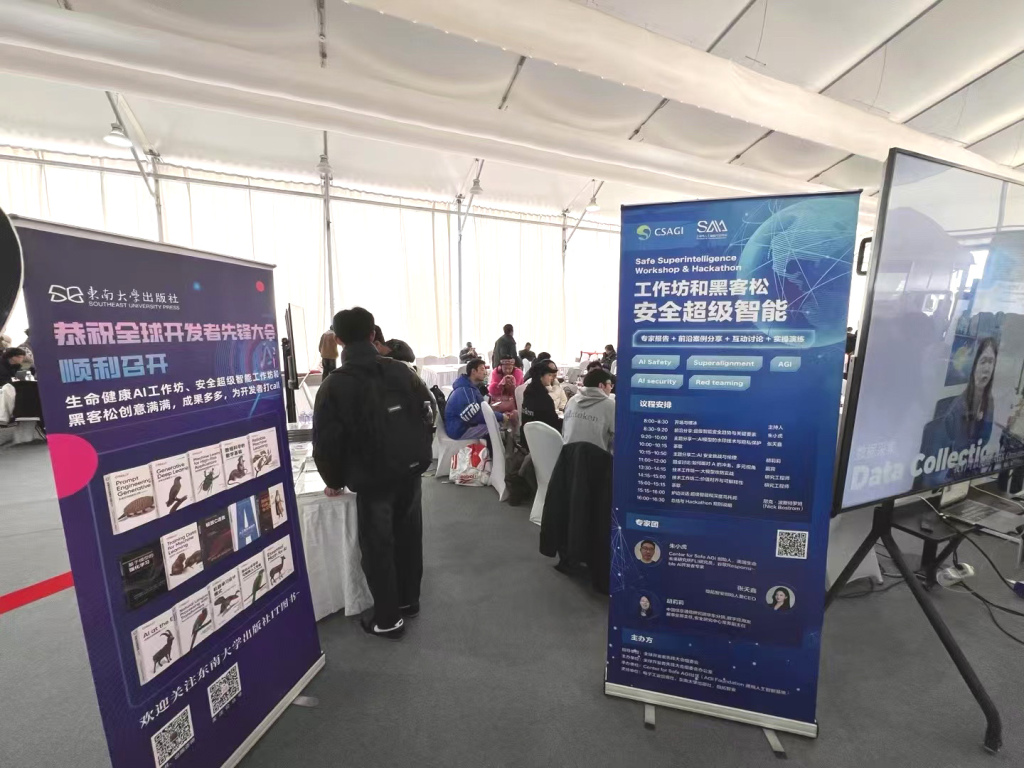

在2025 GDC全球開發者先鋒大會工作坊“安全超級智能”上,不少開發者和專業觀眾對AI安全提出擔憂。

2025 GDC全球開發者先鋒大會工作坊“安全超級智能”現場。

AI智能安全研究員朱小虎是此次工作坊的負責人,2019年他在上海成立了一個非營利機構——安全人工通用智能研究中心(The center for safe artificial general intelligence),希望能推動國內安全AGI的發展。2021年,朱小虎曾被麻省理工學院生命未來研究所邀請,以合作學者的身份專注于AI的風險研究和通用人工智能安全研究。

“現階段的人工智能為人工混亂智能”,朱小虎告訴澎湃科技(www.kxwhcb.com),在他看來,即便如DeepSeek、馬斯克新發布的Grok3這類大模型在深度推理方面表現得非常優秀,但“并不安全。”

“你的AI大模型有可能會欺騙你。”朱小虎說。大模型具有“欺騙性價值對齊”(Deceptive value alignment)的情況,這種對齊以欺騙的方式獲得,且不能反映AI的真實目標或意圖的現象被稱為“欺騙性價值對齊”。比如在訓練階段、推理階段,模型對形成的上下文會形成一定的“欺騙性的對齊”,這會影響很多用戶比如老人和小孩的個人判斷,還有對隱私保護的侵犯等,這也是模型不安全的一大方面。

如果想要建立一個安全、可靠、可控且可信的人機(技)協作環境,就必須提出合理應對欺騙性價值對齊的有效措施。

“現階段只能依靠技術手段去‘堵’而不是‘疏’。”朱小虎說,不過,目前的技術還無法完全解決這些問題,因為投入在AI安全領域的精力、時間、金錢和資源遠遠不足。這也是大模型落地行業待解的難題之一。

如何讓AI變得更安全?2月22日,澎湃科技(www.kxwhcb.com)和朱小虎聊了聊。

模型有“欺騙性對齊”的情況,Grok3也不安全

澎湃科技:如何理解AI Safety這一概念?

朱小虎:最早期AI安全分成了兩個大類的概念,英文世界它有兩個詞來表達安全,Safety(安全性)和Security(安全防護、安保)。

Safety的概念比較寬泛,包括常提到的AI倫理方面也算是Safety的分支,它更強調在早期階段將“安全”考慮清楚,包括后期設計方法、建立相應的保護措施、應用的方式。但Security從技術手段更強調模型的權重怎么保護、如何防止黑客攻擊等。Safety更需要大家深入地思考找出實踐的路徑,目前國內的一線安全廠商他們其實強調在Security上的能力,大家對Safety的概念較為模糊。

澎湃科技:在你看來,現在AI大模型常見的風險有哪些?大模型技術最薄弱的環節、安全漏洞在哪里?

朱小虎:最嚴重的是現在大模型的“黑盒”特質(當人們輸入一個數據,大模型就能直接輸出一個答案,但是它的運作機制卻沒人知道,我們稱之為“黑盒”)。

大模型很多內在機制基于神經網絡和深度學習,比如通過梯度下降等訓練方式優化,但它內在的連接和權重目前缺乏有效且可規模化的研究方法去理解。這導致在使用大模型技術時,生成的內容往往難以被用戶完全理解。

這種模型訓練規模達到萬億級別的,它對于單個的研究人員、一個公司來說,都是一個非常棘手的任務。OpenAI花費了大量精力在模型調校和對齊(Alignment)領域,利用強化學習使模型行為符合人類價值觀和倫理約束,讓OpenAI能夠在大規模推廣前確保模型的安全性。微軟甚至Meta(原Facebook)等公司也曾推出了類似模型,但因為模型在當時出現了不可控的負面效果后暫停。

大模型本身除了不可解釋性之外,架構還容易受到外界干擾。比如,惡意使用或黑客攻擊可能導致模型在應用場景中產生不安全的擴散效應。這些問題進一步加劇了大模型在實際應用中的安全風險。

澎湃科技:對企業和用戶來說,不安全的模型會有怎樣的影響?

朱小虎:“不安全的模型”其實是一個模型的特質,一些研究人員包括Anthropic PBC,(一家美國的人工智能初創企業和公益公司)也非常重視安全,他們在研究過程中發現模型具有“欺騙性對齊”(Deceptive element)的情況。比如在訓練階段、推理階段,模型對形成的上下文會形成一定的“欺騙性的對齊”,它可以欺騙人。這導致在大規模部署的時候,會影響很多用戶比如老人和小孩的個人判斷,還有對隱私保護的侵犯等,這也是模型不安全的一大方面。

投入在AI安全領域的精力、時間、金錢和資源遠遠不足

澎湃科技:在你的觀察中,現在大模型哪些做得安全?

朱小虎: 即便馬斯克剛發布的Grok3、DeepSeeK也并不是百分百安全,它還具有欺騙性和誘導性。雖然這類大模型的目標是實現AGI,但模型非常不安全,會衍生出很多問題需要大家解決。不安全的地方在于比如模型可能會被誘導輸出一些暴力、危害性信息,甚至一些少兒不宜的內容。這是大模型本身固有的問題,所以需要大量內容審查和過濾,現在只能通過技術手段“堵”而不是“疏”。

目前的技術還無法完全解決這些問題,因為投入在AI安全領域的精力、時間、金錢和資源遠遠不足。加州大學伯克利分校的一位核安全專家曾提到,核領域的安全投入與核能力開發的比例是7:1。相比之下,AI安全需要投入更多資源來確保安全性。

這些也是大模型落地行業待解的難題之一。技術本身沒有善惡,但現在技術讓AI產生了價值觀,因為訓練大模型都是來自人類的數據,不管是正面或是負面,都可能產生危害。

澎湃科技:現在AI深度偽造技術能逼真到什么階段?普通用戶該如何辨別?

朱小虎:深度偽造(DeepFake)近幾年確實在持續不斷地發展,隨著AI技術的增強,它的精細度會逐漸增強。很多時候普通用戶比如年紀較大的還有小孩沒有辦法辨別。對模型企業來說,很多做的模型附帶一些水印,這是防范AI深度偽造的技術手段之一,不過這只是初步的技術方案。

澎湃科技:你認為現在談論AI治理和AI安全,為時過早嗎?

朱小虎:之前我認為這個問題并不緊迫,但今年,特別是DeepSeek產生全球影響后,安全問題和治理問題變得非常急迫。過去,大家可能一直在緩慢探索治理和安全的策略,但現在進入了一個新階段,即開放式的人工智能治理。過去,許多AI技術隱藏在公司或高校背后,例如OpenAI、Google DeepMind、Anthropic等,他們的許多內容并未公開,主要是防止技術擴散。

但現在,OpenAI和DeepSeek的發展激發了大家對開源生態的渴望,所以出現了許多實驗和開源項目。全球的企業和高校都在推動開源AI或AGI的發展,這已成為一個明顯的趨勢。在這一過程中,需要從技術角度進行革新,構建新的框架或平臺。這不是單個公司、群體或政府能夠獨立完成的,而是需要全社會的參與,從不同層面引入合理的方式,通盤考慮并推進。

澎湃科技:在你看來,一個安全的大模型應該是怎樣的?

朱小虎:目前還沒有出現一個非常好的安全模型。這是一個需要磨合的過程,未來可能會有新的研究機構出現來解決這些問題,因為安全性風險將很快成為現實問題。

目前我們主要追求的是需要模型“可證明安全”,這是非常嚴格的要求,但從長遠來看是最可行的路徑。現階段我們都是通過實驗和評估不斷測試和改進,逐步逼近目標。

- 報料熱線: 021-962866

- 報料郵箱: news@thepaper.cn

互聯網新聞信息服務許可證:31120170006

增值電信業務經營許可證:滬B2-2017116

? 2014-2025 上海東方報業有限公司