- +1

MiniMax發布新一代開源模型,首次大規模實現線性注意力機制

1月15日,澎湃科技(www.kxwhcb.com)獲悉,AI獨角獸企業MiniMax上海稀宇科技有限公司(以下簡稱“MiniMax”)發布并開源新一代01全新系列模型。該系列模型包含基礎語言大模型MiniMax-Text-01和視覺多模態大模型MiniMax-VL-01。MiniMax稱該系列模型可以實現高效超長文本輸入。MiniMax認為,2025年將是Agent高速發展的關鍵年份,無論是單Agent系統還是多Agent系統,都需要更長的上下文來支持持續記憶和大量通信。

據了解,MiniMax-01系列模型首次大規模實現線性注意力機制,傳統Transformer架構不再是唯一的選擇。

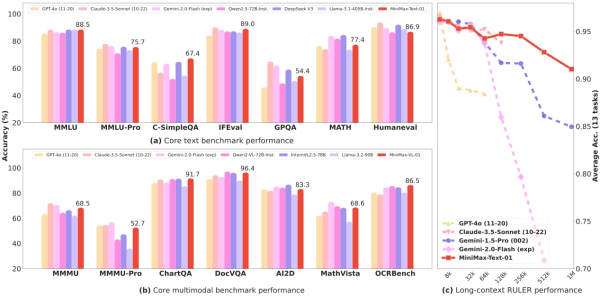

MiniMax-01系列模型核心性能在多項任務評測結果顯示結果

目前領先的大語言模型大都基于Transformer架構,而Transformer核心的自注意力機制是其計算成本的重要來源。為了優化計算效率,MiniMax研究社區提出了稀疏注意力、低秩分解和線性注意力等許多技術。通過使用線性注意力,原生Transformer的計算復雜度可從二次復雜度大幅下降到線性復雜度,在處理長輸入的時候具有非常高的效率。

據了解,該模型的參數量高達4560億,其中單次激活459億。模型綜合性能比肩海外頂尖模型,同時能夠高效處理全球最長400萬token的上下文,是GPT-4o的32倍,Claude-3.5-Sonnet的20倍。

MiniMax認為,2025年將是Agent高速發展的關鍵年份,無論是單Agent系統還是多Agent系統,都需要更長的上下文來支持持續記憶和大量通信。MiniMax-01系列模型的推出,正是為了滿足這一需求,邁出建立復雜Agent基礎能力的第一步。

此外,MiniMax聲稱受益于架構的創新、效率的優化、集群訓推一體的設計以及內部大量并發算力復用,得以用業內最低的價格區間提供文本和多模態理解的API,標準定價是輸入token1元/百萬token,輸出token8元/百萬token。

目前,MiniMax-01系列開源模型已應用于MiniMax旗下產品海螺AI,并在全球范圍內上線,企業與個人開發者可前往MiniMax開放平臺使用API。

- 報料熱線: 021-962866

- 報料郵箱: news@thepaper.cn

互聯網新聞信息服務許可證:31120170006

增值電信業務經營許可證:滬B2-2017116

? 2014-2025 上海東方報業有限公司