- +1

黃仁勛對話Transformer論文作者:世界需要比Transformer更好的東西

原創(chuàng) 蘇霍伊 劉楊楠 甲子光年

一場堪比“世界名畫”的圓桌討論。

作者|蘇霍伊 劉楊楠

編輯|甲小姐 王博

發(fā)自美國圣何塞(San Jose)GTC現(xiàn)場

今年的英偉達(dá)GTC,英偉達(dá)創(chuàng)始人&CEO黃仁勛在主題演講之外,公開的活動就只有一場圓桌討論——Transforming AI。

當(dāng)?shù)貢r間早上7:00,距離這場圓桌討論開始還有4個小時,就有觀眾來到了圣何塞McEnery會議中心。圓桌討論開始前1個小時,門口已經(jīng)排起長龍。

GTC現(xiàn)場,圖片來源:「甲子光年」拍攝

觀眾如此關(guān)注這場圓桌討論的原因除了黃仁勛之外,還有英偉達(dá)預(yù)告的重磅嘉賓:Ashish Vaswani、Noam Shazeer、Niki Parmar、Jakob Uszkoreit、Llion Jones、Aidan Gomez、Lukasz Kaiser和Illia Polosukhin。

他們都曾就職于Google,也是論文《Attention Is All You Need(注意力就是你所需要的一切)》的作者,被稱為——“Transformer論文八子”,而這篇論文也被稱為“夢開始的地方”。

2017年,Google團(tuán)隊發(fā)表了一篇文章《Attention Is All You Need》。這篇開創(chuàng)性的論文介紹了基于Transformer的深度學(xué)習(xí)架構(gòu)。Transformer徹底改變了自然語言處理(NLP)領(lǐng)域,它的自注意力機(jī)制也被廣泛應(yīng)用于計算機(jī)視覺等其他領(lǐng)域,并對AI研究產(chǎn)生了深遠(yuǎn)影響,成為了AI發(fā)展史上的一個里程碑。截至今天,這篇論文的被引用次數(shù)已高達(dá)112576。

黃仁勛也是這篇論文的“受益者”之一。

如果說ChatGPT是席卷AI行業(yè)的一場“風(fēng)暴”,那么Transformer就是“扇動翅膀”的那只蝴蝶;如果說英偉達(dá)是AI時代的“賣鏟人”,那么這篇論文帶來的巨大算力需求就是其背后的底氣。

俗話說“吃水不忘挖井人”,黃仁勛這次把這篇論文的七位作者(Niki Parmar家有急事未能到場參會)都邀請到了現(xiàn)場,在此之前,他們從未以這樣的形式出現(xiàn)在同一場合解讀Transformer。

Transforming AI圓桌討論到場嘉賓及職務(wù),圖片來源:英偉達(dá)GTC

值得一提的是,到場的七位嘉賓中,除了Lukasz Kaiser在OpenAI擔(dān)任工程師,其他人都在創(chuàng)業(yè)。

“這年頭大家創(chuàng)業(yè)的公司名稱幾乎都包含‘AI’,”黃仁勛在介紹到場嘉賓時說,“其實我們NVIDIA的名字也包含‘AI’,只不過字母順序反了。我一直都知道我需要字母A和字母I。”黃仁勛的幽默引發(fā)了全場的笑聲。

面對七位嘉賓,黃仁勛像一位綜藝節(jié)目主持人一樣問了很多直白樸素的問題:

這個主意怎么想出來的?

為什么要起這樣一個論文標(biāo)題?

Transformer這個詞是怎么來的?當(dāng)時還有其他可選的詞嗎?

新的模型技術(shù)將是什么?

你們想要探索什么?

七位嘉賓分別回答了相關(guān)問題,不過Cohere聯(lián)合創(chuàng)始人&CEO Aidan Gomez說出了一句意味深長的話:“我們希望世界可以誕生比Transformer更好的東西。”

1.“RNN是蒸汽機(jī),Transformer是內(nèi)燃機(jī)”

“你們能來真的太好了!”黃仁勛說,“今天我們所享受的一切,都能追溯到Transformer出現(xiàn)的那一刻,我們從大量的數(shù)據(jù)中學(xué)習(xí),以一種有序的方式,有序的數(shù)據(jù)以及空間數(shù)據(jù),但從大量的數(shù)據(jù)中學(xué)習(xí)來找到關(guān)系和模式,并創(chuàng)建這些巨大的模型是非常具有變革性的。”

這場圓桌討論由于觀眾太過熱情,導(dǎo)致開始的時間有些推遲,不過黃仁勛希望現(xiàn)場氛圍更熱烈,他告訴七位嘉賓:“今天坐到這里,請大家積極爭搶發(fā)言的機(jī)會,在這里沒有什么話題是不能談的,你們甚至可以椅子上跳起來討論問題。”

隨著黃仁勛拋出第一個問題“是什么驅(qū)動你們創(chuàng)造出了Transformer”,圓桌討論正式開始。

Transformer的最初目標(biāo)是解決一個樸素的問題——機(jī)器翻譯。

NEAR Protocol聯(lián)合創(chuàng)始人Illia Polosukhin表示:“我們通常遇到問題就會去Google搜索,但如果需要在它反饋回來的‘成噸’網(wǎng)頁中做快速處理,當(dāng)時的RNN(循環(huán)神經(jīng)網(wǎng)絡(luò))是無法做到的。因為它們需要逐個單詞地處理文本。”

Inceptive聯(lián)合創(chuàng)始人&CEO Jakob Uszkoreit回憶,他們最初的目標(biāo)是解決處理序列數(shù)據(jù)(如文本、音頻等)的問題。在一個特定時期,由于生成訓(xùn)練數(shù)據(jù)的速度遠(yuǎn)超過訓(xùn)練復(fù)雜神經(jīng)網(wǎng)絡(luò)架構(gòu)的能力,因此在實際應(yīng)用中更傾向于使用簡單且訓(xùn)練速度更快的模型,如以n-gram為輸入特征的前饋神經(jīng)網(wǎng)絡(luò)。

“在擁有大量訓(xùn)練數(shù)據(jù)的情況下,更簡單的模型架構(gòu)(例如,僅包含前饋網(wǎng)絡(luò)的模型)在處理大規(guī)模數(shù)據(jù)時表現(xiàn)得比更復(fù)雜的RNN和LSTM更好,因為它們的訓(xùn)練速度更快。”Jakob Uszkoreit說。

Character.AI聯(lián)合創(chuàng)始人&CEO Noam Shazeer當(dāng)時主要關(guān)注在自注意力(self-attention)機(jī)制的引入和模型的擴(kuò)展性上,“我們在2015年左右就注意到這些Scaling law(規(guī)模法則)。”

他還幽默地表示:“RNN就像蒸汽機(jī)一樣,而Transformer模型則像內(nèi)燃機(jī)。我們當(dāng)然可以在坐在蒸汽機(jī)上完成工業(yè)革命,只不過‘屁股會燒很疼’,內(nèi)燃機(jī)的效果則要好得多!”

Essential AI聯(lián)合創(chuàng)始人&CEO Ashish Vaswani則更傾向讓模型自主學(xué)習(xí)并設(shè)計一個具有廣泛適用性的框架,他用之前在工作中遇到的兩個教訓(xùn)闡述了自己的思考。

“第一個教訓(xùn)是,我們需要明白梯度下降(gradient descent)是一位出色的老師。”Ashish Vaswani在研究機(jī)器翻譯時領(lǐng)悟道相比于自己去學(xué)習(xí)語言規(guī)則,讓梯度下降這種訓(xùn)練模型的算法來處理會更高效。

“第二個教訓(xùn)是,可擴(kuò)展的通用架構(gòu)一定會勝利的。”談到這里時,Ashish Vaswani用了“苦澀的教訓(xùn)”(bitter lesson)的說法,即那些可以擴(kuò)展并且具有通用性的架構(gòu)最終會更勝一籌,“能夠像Transformer一樣處理各種不同任務(wù)和數(shù)據(jù)類型的模型,一定會比專為特定任務(wù)設(shè)計的模型效果更好。”

OpenAI技術(shù)團(tuán)隊成員Lukasz Kaiser和Sakana AI聯(lián)合創(chuàng)始人&CTO Llion Jones也分享了他們對模型直觀性的看法,尤其是在機(jī)器翻譯領(lǐng)域的應(yīng)用。同時,他們也提到了如何通過消融實驗(移除模型的一部分)來改進(jìn)模型性能。

《Attention is all you need》這個論文標(biāo)題是Llion Jones想到的,他還透露,起標(biāo)題時只是在做“消融術(shù)”(ablations)。

至于Transformer這個名字,則是由Jakob Uszkoreit提議的。他的理由非常直接,因為模型改變了他們處理數(shù)據(jù)的方式,所有的機(jī)器學(xué)習(xí)都是“Transformer”,都是顛覆者。

Noam Shazee提到他之前想過很多名字,比如“Cargornet”(貨運網(wǎng)),但投票沒有通過。

“還好被否決了。”黃仁勛調(diào)侃了一句。

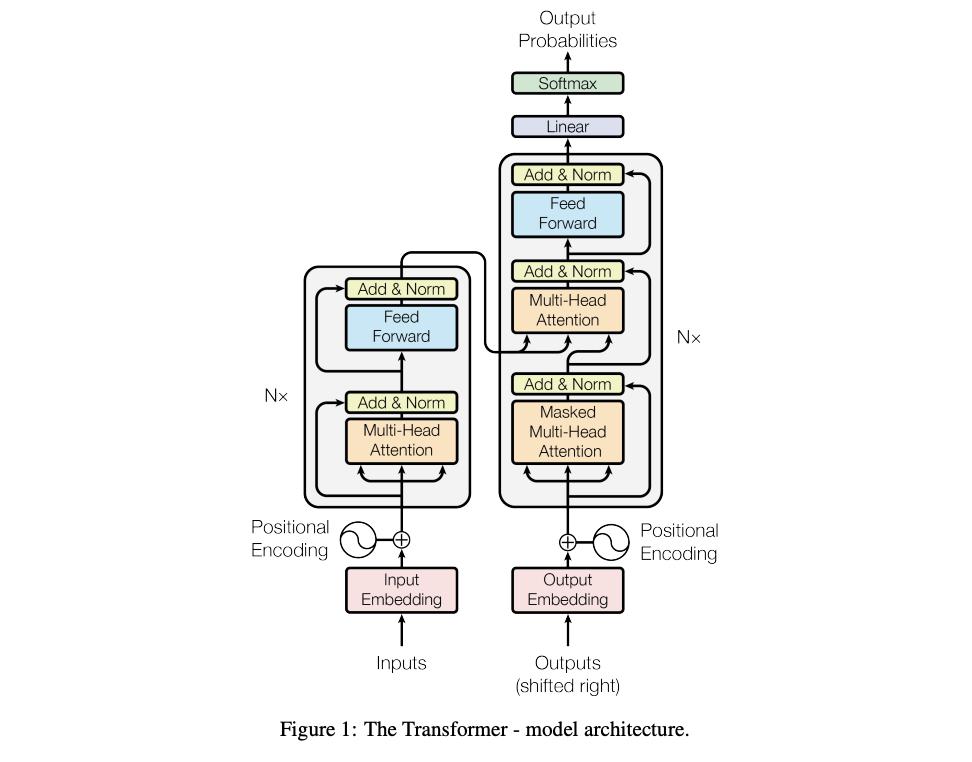

“Transformer”這個名字體現(xiàn)了它的核心能力:能夠全面且廣泛地轉(zhuǎn)換數(shù)據(jù)。Transformer完全拋棄了RNN的邏輯,由自注意力機(jī)制組成。這一點與人腦處理信息時的方式不謀而合。人腦在理解句子時能自然地忽略次要細(xì)節(jié),更專注于關(guān)鍵信息。Transformer就采用了類似的策略,能夠識別并理解序列數(shù)據(jù)中不同元素之間的相關(guān)性,從而提高數(shù)據(jù)處理的效率和準(zhǔn)確性。

通過這個技術(shù),模型能夠在處理文本、音頻等連續(xù)數(shù)據(jù)時,更加靈活、高效地調(diào)整信息,得到更準(zhǔn)確、內(nèi)容更豐富的結(jié)果。

Jakob Uszkoreit還強(qiáng)調(diào)了Transformer模型的一個關(guān)鍵能力:它能夠在每一步處理時都全面轉(zhuǎn)換它正在處理的信息,而不是僅僅關(guān)注信息的一小部分。這種全方位的處理能力也是它命名為“Transformer”的原因之一。

Transformer模型架構(gòu),圖片來源:《Attention is all you need》

Transformer帶來的另一個重要創(chuàng)新是,能夠利用并行計算極大地加速深度學(xué)習(xí)模型的訓(xùn)練過程。這為大規(guī)模預(yù)訓(xùn)練模型的發(fā)展奠定了基礎(chǔ),開啟了邁向通用人工智能(AGI)之路。

而GPU非常適合并行計算,擅長研發(fā)、生產(chǎn)GPU的英偉達(dá)由此成為了AI時代“賣鏟人”。黃仁勛也從當(dāng)年在小米手機(jī)活動上自稱的“米粉”,變成了AI行業(yè)中幾乎所有人都想接近的“AI教主”。

除了在自然語言處理領(lǐng)域取得的成績,Transformer技術(shù)還被廣泛應(yīng)用于語音識別和計算機(jī)視覺等多個領(lǐng)域,證明了其在處理各種序列數(shù)據(jù)上的通用性和有效性。正是這些創(chuàng)新的技術(shù),推動了人工智能領(lǐng)域的快速發(fā)展,讓我們能夠預(yù)見到一個與智能機(jī)器無縫交流的未來。

2.“世界需要比Transformer更好的東西”

Transformer的問世,離不開這篇論文每一位作者的付出。

最初是Jakob Uszkoreit提出了用自注意力機(jī)制替換RNN的想法,并評估了這一想法;

Ashish Vaswani與Illia Polosukhin一起設(shè)計并實現(xiàn)了第一個Transformer模型;

Noam Shazeer提出了縮放點積注意力、多頭注意力和無參數(shù)位置表示;

Niki Parmar在原始代碼庫和tensor2tensor中設(shè)計、實現(xiàn)、調(diào)優(yōu)和評估了無數(shù)模型變體;

Llion Jones嘗試了新型模型變體,他主要負(fù)責(zé)最初的代碼庫,以及高效推理和可視化;

Lukasz Kaiser和Aidan Gomez花費了無數(shù)漫長的時間設(shè)計和實現(xiàn)了tensor2tensor的各個部分,取代了早期的代碼庫,加快了研究進(jìn)程。

現(xiàn)在,Transformer創(chuàng)造者的目光已經(jīng)不再局限于Transformer。他們在不同的領(lǐng)域,共同探討著下一步的AI走向。

“世界需要比Transformer更好的東西(the world needs something better than Transformers)。”Aidan Gomez語氣很堅定。

他認(rèn)為,如果Transformer是他們能做到的極致,“這會很可悲”,但他話鋒一轉(zhuǎn)又說道:“雖然提交報告的第二天起我就這么認(rèn)為了。我希望它能被其他好10倍的框架取代,這樣每個人都能擁有更好10倍的模型!”

目前,Transformer的內(nèi)存方面存在許多效率低下的問題,且許多架構(gòu)組件從一開始就保持不變,應(yīng)該“重新探索、重新考慮”。例如,一個很長的上下文會變得昂貴且無法擴(kuò)展。此外,“參數(shù)化可能不必要地大,我們可以進(jìn)一步壓縮它,我們可以更頻繁地共享權(quán)重——這可能會將事情降低一個數(shù)量級。”

Jakob Uszkoreit進(jìn)一步解釋道:“未來重點要思考的是如何分配資源,而不是一共消耗了多少資源。我們不希望在一個容易得問題上花太多錢,或者在一個太難的問題上花太少而最終得不到解決方案。”

“例如‘2+2=4’,如果你正確地將他輸入到這個模型中,它就會使用一萬億個參數(shù)。所以我認(rèn)為自適應(yīng)計算是接下來必須出現(xiàn)的事情之一,我們知道在特定問題上應(yīng)該花費多少計算資源。”Illiya Polosukhin補(bǔ)充。

Lukasz Kaiser對此也有思考,他認(rèn)為,根本性問題在于,哪些知識應(yīng)該內(nèi)置于模型之中,哪些知識應(yīng)該置于模型之外?“是使用檢索模型嗎?RAG(Retrieval-Augmented Generation)模型就是一個例子。”

同樣地,這也涉及到推理問題,即哪些推理任務(wù)應(yīng)該通過外部的符號系統(tǒng)來完成,哪些推理任務(wù)應(yīng)該直接在模型內(nèi)部執(zhí)行。這在很大程度上是一個關(guān)于效率的討論。我確實相信,大型模型最終會學(xué)會如何進(jìn)行‘2+2’這樣的計算,但如果你要計算‘2+2’,卻通過累加數(shù)字來進(jìn)行,那顯然是低效的。”

黃仁勛回應(yīng)道:“如果AI只需要計算2+2,那么它應(yīng)該直接使用計算器,用最少的能量來完成這個任務(wù)。”

“確實如此,但我同樣確信在座的各位所研發(fā)的人工智能系統(tǒng)都足夠智能,能夠主動使用計算器,”Noam Shazeer說,“目前全球公共產(chǎn)品(GPP)正是這樣做的。我認(rèn)為當(dāng)前的模型太過經(jīng)濟(jì)實惠,規(guī)模也還太小。它之所以便宜,是因為像英偉達(dá)這樣的技術(shù),感謝它的產(chǎn)出。”

此前Noam Shazeer在接受采訪時就認(rèn)為,AGI是很多AI初創(chuàng)企業(yè)的目標(biāo)。但他創(chuàng)業(yè)的真正原因是想推動技術(shù)發(fā)展,用技術(shù)攻克難題,如醫(yī)學(xué)上的疑難雜癥。他指出,AI能加速許多研究的進(jìn)程,與其直接研究醫(yī)學(xué),不如研究AI。

他在圓桌討論現(xiàn)場也表達(dá)了類似的觀點:“如果你觀察一個擁有五千億參數(shù)的模型,并且每個token進(jìn)行一萬億次計算,那就大概是1美元百萬token,這比外出購買一本平裝書并閱讀的成本要便宜100倍。我們的應(yīng)用程序在價值上比巨型神經(jīng)網(wǎng)絡(luò)上的高效計算高出百萬倍或更多。我的意思是,它們無疑比治愈癌癥等事情更有價值,但不僅如此。”

Ashish Vaswani認(rèn)為讓世界變得更“聰明”,就是指——如何去獲得來自于世界的反饋,我們能否實現(xiàn)多任務(wù)、多線的并行。“如果你真的想構(gòu)建這樣一個模型,幫助我們設(shè)計這樣一個模型,這是一種非常好的方式。”他說。

盡管其他嘉賓亦有共鳴,但Aidan Gomez認(rèn)為大家對于“這一改變會在何時發(fā)生”持有不同的看法,“人們對于它是否真的會發(fā)生也各有立場,但無一例外,大家都渴望看到進(jìn)步,好像我們每個人的內(nèi)心都住著一個小小的科學(xué)家,都想看到事情變得更好!”

在討論中,Llion Jones還提出了一個觀點:要想讓AI真正向前邁進(jìn),超越當(dāng)前的技術(shù)模型,不僅僅是做得更好那么簡單,“你得做到顯著優(yōu)秀,讓人一看就知道。”在他看來,盡管技術(shù)上可能有更先進(jìn)的模型存在,但當(dāng)前的進(jìn)展似乎還是停留在了原點。

Aidan Gomez對此表示認(rèn)同,他認(rèn)為Transformer之所以受到追捧,不單單是因為它本身的優(yōu)勢,更因為人們對它的熱情。“兩者缺一不可。”他解釋道,“如果你沒能同時抓住這兩點,就很難推動整個社區(qū)前進(jìn)。如果想要促成從一種架構(gòu)向另一種架構(gòu)的轉(zhuǎn)變,你確實需要拿出一些能夠激發(fā)大家興趣的東西。”

3.“你不會希望錯過未來十年”

那么,生成式AI到底意味著什么?

黃仁勛在現(xiàn)場分享道:“生成式AI,是一種全新的軟件,它也能夠創(chuàng)造軟件,它還依賴于眾多科學(xué)家的共同努力。想象一下,你給AI‘原材料’——數(shù)據(jù),讓它們進(jìn)入一棟‘建筑’——我們稱之為GPU,它就能輸出神奇的結(jié)果。它正在重塑一切,我們正在見證AI工廠的誕生。”

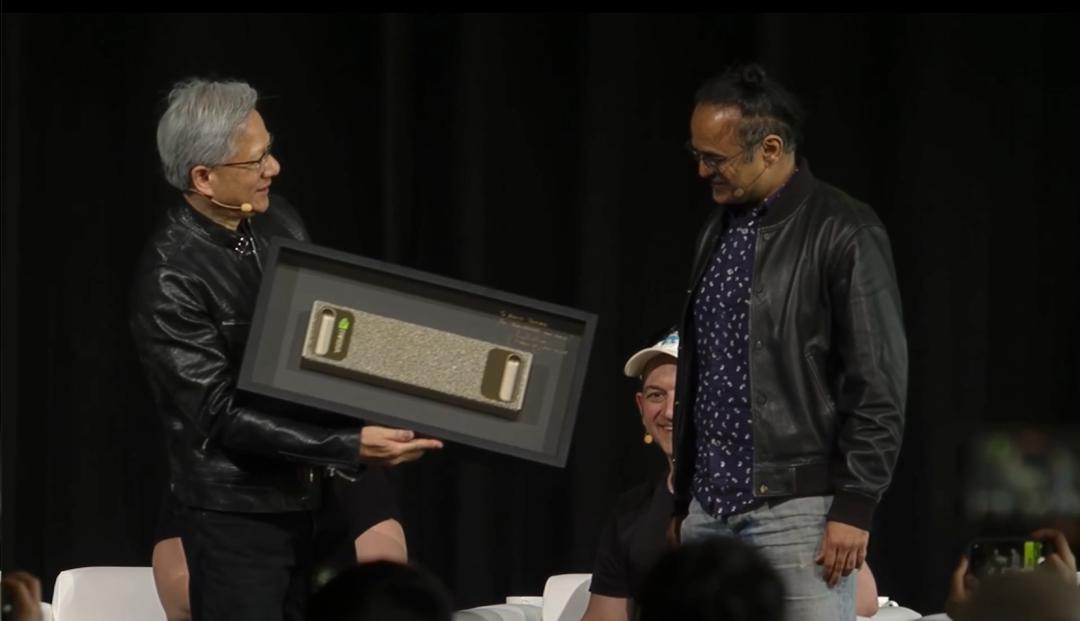

圓桌對話結(jié)束后,黃仁勛特意拿出DGX-1——一款專為深度學(xué)習(xí)和AI研究設(shè)計的高性能計算平臺,送給了Ashish Vaswani,DGX-1上面寫著一句話“You transformed the world”(你改變了世界)。

黃仁勛(左)與Ashish Vaswani(右),圖片來源:英偉達(dá)GTC

這像是一次call back。2016年,黃仁勛向OpenAI捐贈了首臺DGX-1,當(dāng)時接收這一禮物的是——埃隆·馬斯克(Elon Musk)。

黃仁勛向OpenAI捐贈DGX-1,圖片來源:馬斯克社交媒體賬號

黃仁勛在DGX-1上寫到:To Elon & the OpenAI Team! To the future of computing and humanity. I present you the World's First DGX-1!

翻譯過來就是:致埃隆和OpenAI團(tuán)隊!致計算和人類的未來。我為你們呈上世界上首臺DGX-1!

曾經(jīng)的“Transformer論文八子”,如今都成為了獨當(dāng)一面的“狠角色”,他們每個人都是在Google成長,又先后從Google離開,大家見證了“Transformer Mafia”(致敬“PayPal Mafia”)的誕生,也看到了他們在硅谷中開枝散葉、生生不息。

“你不會希望錯過未來十年。”黃仁勛說。

(封面圖來源:「甲子光年」拍攝)

END

原標(biāo)題:《黃仁勛對話Transformer論文作者:世界需要比Transformer更好的東西|甲子光年》

本文為澎湃號作者或機(jī)構(gòu)在澎湃新聞上傳并發(fā)布,僅代表該作者或機(jī)構(gòu)觀點,不代表澎湃新聞的觀點或立場,澎湃新聞僅提供信息發(fā)布平臺。申請澎湃號請用電腦訪問http://renzheng.thepaper.cn。

- 報料熱線: 021-962866

- 報料郵箱: news@thepaper.cn

互聯(lián)網(wǎng)新聞信息服務(wù)許可證:31120170006

增值電信業(yè)務(wù)經(jīng)營許可證:滬B2-2017116

? 2014-2025 上海東方報業(yè)有限公司