- +1

英偉達自己超越自己,H200取代H100成為新的最強AI芯片

·對比備受熱捧的H100芯片,新的H200完成了1.4倍內(nèi)存帶寬和1.8倍內(nèi)存容量的升級,提高了處理密集生成式人工智能負載的能力。據(jù)介紹,在處理Meta的大語言模型Llama2(700億參數(shù))時,H200的推理速度比H100提高了2倍。

·第一批H200芯片將于2024年第二季度上市。

第一批H200芯片將于2024年第二季度上市。

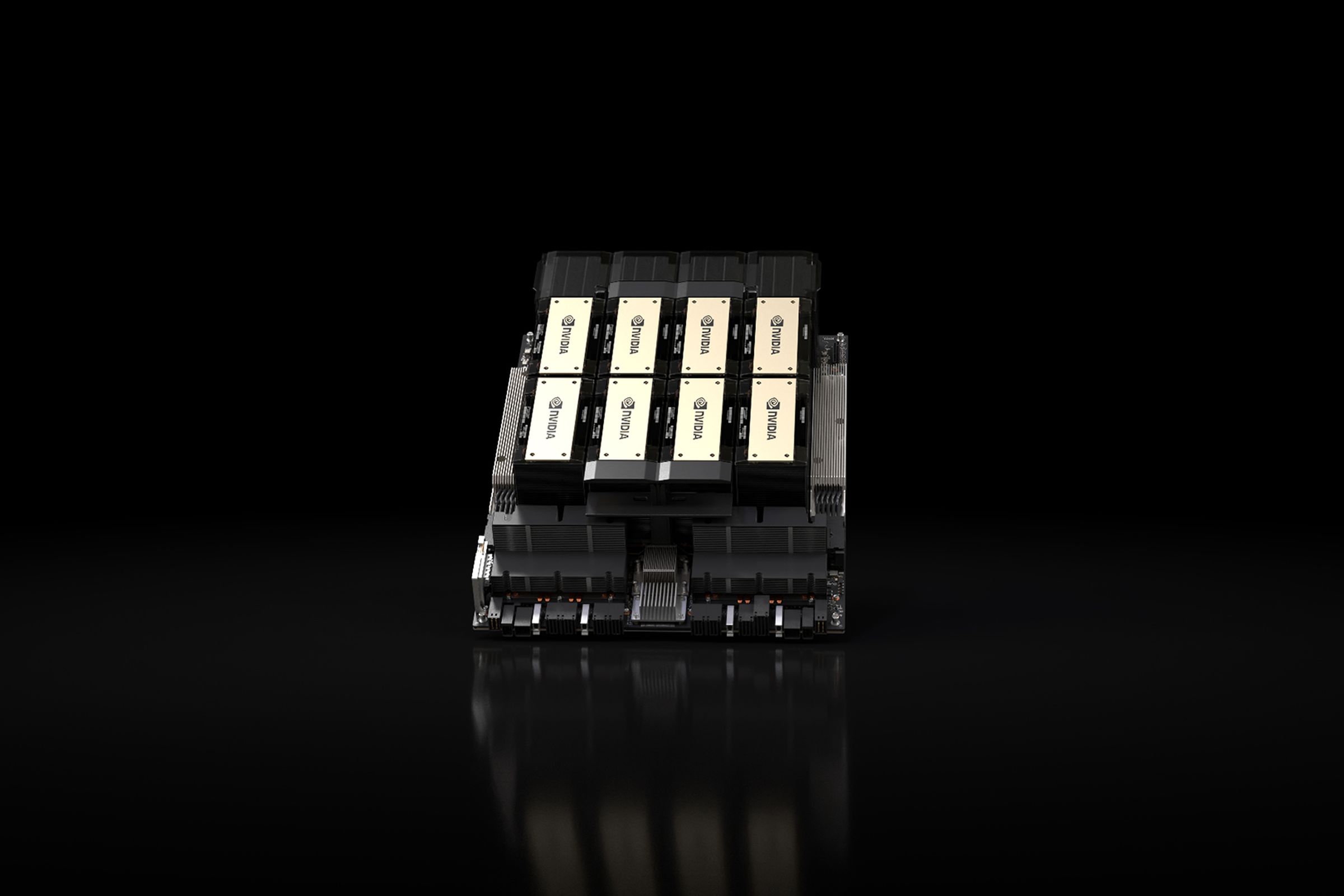

北京時間11月14日凌晨,英偉達在今年的SC23大會上突然宣布,推出新的頂級AI芯片HGX H200。第一批H200芯片將于2024年第二季度上市。

英偉達又一次自己超越自己,H200取代H100成為新的世界最強AI芯片。

對比備受熱捧的H100芯片,這款新的GPU(圖形處理單元)完成了1.4倍內(nèi)存帶寬和1.8倍內(nèi)存容量的升級,提高了處理密集生成式人工智能負載的能力。據(jù)介紹,在處理Meta的大語言模型Llama2(700億參數(shù))時,H200的推理速度比H100提高了2倍。

從外觀上看,H200似乎與H100基本相同。內(nèi)存方面,H200芯片是第一款采用HBM3e(新型超高速高帶寬內(nèi)存)的GPU。HBM3e可加速生成式AI和大語言模型工作負載,將GPU的內(nèi)存帶寬提高到每秒4.8TB,而H100為每秒3.35TB,同時將其總內(nèi)存容量提高到141GB,而其前身為80GB。與再前一代的A100相比,其容量翻倍,帶寬增加2.4倍。

對于高性能計算(HPC),顯存帶寬也至關(guān)重要,其可以實現(xiàn)更快的數(shù)據(jù)傳輸,減少復(fù)雜任務(wù)的處理瓶頸。對于模擬、科學(xué)研究和人工智能等顯存密集型HPC應(yīng)用,H200更高的顯存帶寬可確保高效地訪問和操作數(shù)據(jù)。據(jù)介紹,相較于H100,H200在處理高性能計算的應(yīng)用程序上有20%以上的提升。

英偉達大規(guī)模與高性能計算副總裁伊恩·巴克(Ian Buck)在演示視頻中表示,“HBM內(nèi)存的整合有助于加速計算密集任務(wù)的性能,包括生成式人工智能模型和高性能計算應(yīng)用,同時優(yōu)化GPU的利用率和效率。”“借助H200,業(yè)界領(lǐng)先的端到端人工智能超算平臺的速度會變得更快,一些世界上最重要的挑戰(zhàn),都可以被解決。”

H200還與支持H100的系統(tǒng)兼容。英偉達表示,云服務(wù)提供商在添加H200時無需進行任何更改。亞馬遜、谷歌、微軟和甲骨文等公司的云服務(wù)部門將是明年首批接收新GPU的公司。

除了各種芯片性能升級外,一個重要的關(guān)注點在于公司是否能夠得到這些新芯片,或者它們是否會像H100一樣受到供應(yīng)限制。對于這個問題,英偉達并沒有確切的答案。該公司表示正在與“全球系統(tǒng)制造商和云服務(wù)提供商”合作,以使其可用。英偉達發(fā)言人克里斯汀·內(nèi)山(Kristin Uchiyama)拒絕就生產(chǎn)數(shù)量發(fā)表評論。

此外,價格也是核心焦點。英偉達目前沒有列出新芯片的價格,內(nèi)山表示定價由英偉達的合作伙伴確定。據(jù)美國媒體CNBC報道,上一代H100估計每個售價在25000到40000美元之間,要想在最高水平上運行,可能需要數(shù)千個H100芯片。

目前全球的人工智能公司還面臨著“算力荒”,急切尋找H100芯片成為常態(tài)(H100被視為高效訓(xùn)練和運行生成式人工智能和大語言模型的最佳選擇)。這些芯片已經(jīng)成為了“硬通貨”,甚至有公司將H100芯片用作貸款的抵押品,在硅谷誰擁有多少H100芯片也是熱門的八卦話題。

內(nèi)山在接受科技媒體The Verge的采訪中表示,H200的推出不會影響H100的生產(chǎn),“你將看到我們在整個年度增加總體供應(yīng)”。據(jù)《金融時報》8月報道,英偉達計劃在2024年將H100的生產(chǎn)量增加到三倍,目標是明年生產(chǎn)200萬個(2023年生產(chǎn)約50萬個)。

- 報料熱線: 021-962866

- 報料郵箱: news@thepaper.cn

互聯(lián)網(wǎng)新聞信息服務(wù)許可證:31120170006

增值電信業(yè)務(wù)經(jīng)營許可證:滬B2-2017116

? 2014-2025 上海東方報業(yè)有限公司