- +1

上海AI實驗室發布“書生·浦語”大模型:在高考等評測中表現優秀

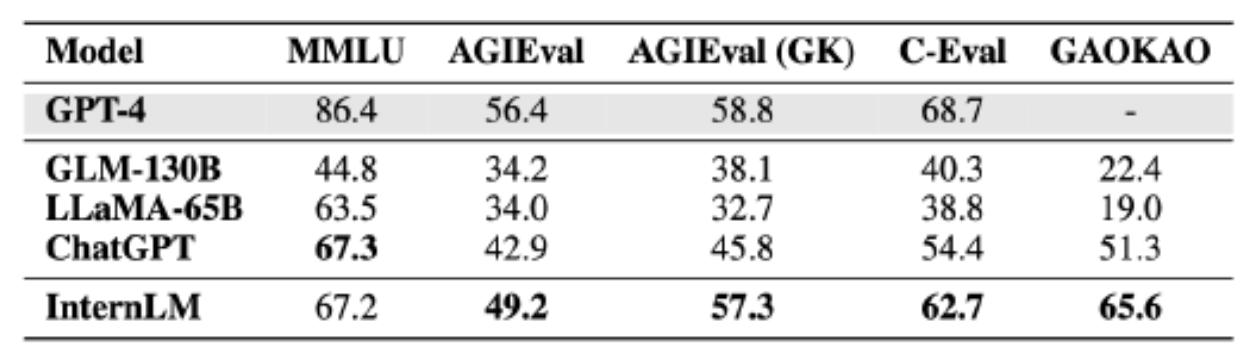

·“書生·浦語”聯合團隊選取了20余項評測對其進行檢驗,其中包含全球最具影響力的四個綜合性考試評測集,對“書生·浦語”、清華大學的GLM-130B、Meta的LLaMA-65B、OpenAI的ChatGPT和GPT-4進行了全面測試。

6月7日,上海人工智能實驗室(上海AI實驗室)、商湯科技聯合香港中文大學、復旦大學及上海交通大學發布千億級參數大語言模型“書生·浦語”(InternLM),具有1040億參數,在多項中文考試中取得超越ChatGPT的成績,在數學考試中成績明顯領先于谷歌、Meta的大模型。

“書生·浦語”聯合團隊選取了20余項評測對其進行檢驗,其中包含全球最具影響力的四個綜合性考試評測集:由伯克利加州大學等高校構建的多任務考試評測集MMLU;微軟研究院推出的學科考試評測集AGIEval(含中國高考、司法考試及美國SAT、LSAT、GRE 和 GMAT等),AGIEval的19個評測大項中有9個大項是中國高考,通常也列為一個重要的評測子集AGIEval(GK);由上海交通大學、清華大學和愛丁堡大學合作構建的面向中文語言模型的綜合性考試評測集C-Eval;以及由復旦大學研究團隊構建的高考題目評測集Gaokao。

實驗室聯合團隊對“書生·浦語”、清華大學的GLM-130B、Meta的LLaMA-65B、OpenAI的ChatGPT和GPT-4進行了全面測試,針對上述四個評測集的成績對比如下(滿分100分)。

“書生·浦語”、GLM-130B、LLaMA-65B、ChatGPT和GPT-4的測試結果。

據上海人工智能實驗室消息,“書生·浦語”全面評測結果顯示,其在知識掌握、閱讀理解、數學推理、多語翻譯等多個測試任務上表現優秀,在綜合性考試中表現突出,在多項中文考試中取得超越ChatGPT的成績,其中就包括中國高考各科目的數據集(GaoKao),在以美國考試為主的MMLU上和ChatGPT基本持平。

為了避免“偏科”,研究人員通過多個學術評測集,對“書生·浦語”等語言模型的分項能力進行了評測對比。結果顯示,“書生·浦語”不僅在中英文的閱讀理解方面表現突出,并且在數學推理、編程能力等評測中也取得了較好的成績。

分項能力的評測對比。

在英語閱讀理解方面,“書生·浦語”明顯領先于LLaMA-65B和ChatGPT,“書生·浦語”在初中和高中英語閱讀理解中得分為92.7和88.9,?ChatGPT得分為85.6和81.2,LLaMA-65B則更低。在數學推理方面,“書生·浦語”在GSM8K和MATH這兩項被廣泛用于評測的數學考試中,分別取得62.9和14.9的得分,明顯領先于谷歌的PaLM-540B(得分為56.5和8.8)與LLaMA-65B(得分為50.9和10.9)。

但在測評中也可以看到,大語言模型仍然存在能力局限。“書生·浦語” 受限于2K的語境窗口長度(GPT-4的語境窗口長度為32K),在長文理解、復雜推理、撰寫代碼以及數理邏輯演繹等方面還存在明顯局限。另外,在實際對話中,大語言模型還普遍存在幻覺、概念混淆等問題。這些局限使得大語言模型在開放場景中的使用還有很長的路要走。

- 報料熱線: 021-962866

- 報料郵箱: news@thepaper.cn

互聯網新聞信息服務許可證:31120170006

增值電信業務經營許可證:滬B2-2017116

? 2014-2025 上海東方報業有限公司