- +1

AI社會學|社交媒體上的我們?yōu)槭裁慈绱藨嵟?/h1>沈虹字號不久前,我系畢業(yè)的博士生約瑟夫·斯蒂爾(Joseph Steering)做了一個超級可愛的論文。

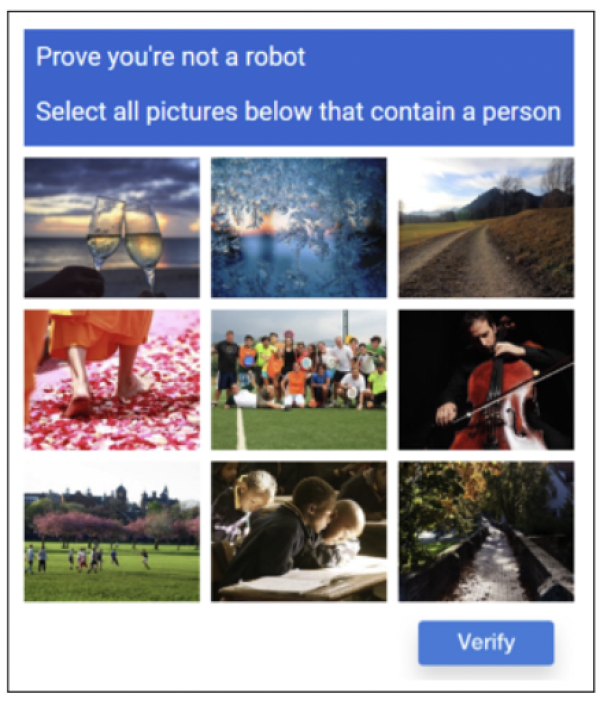

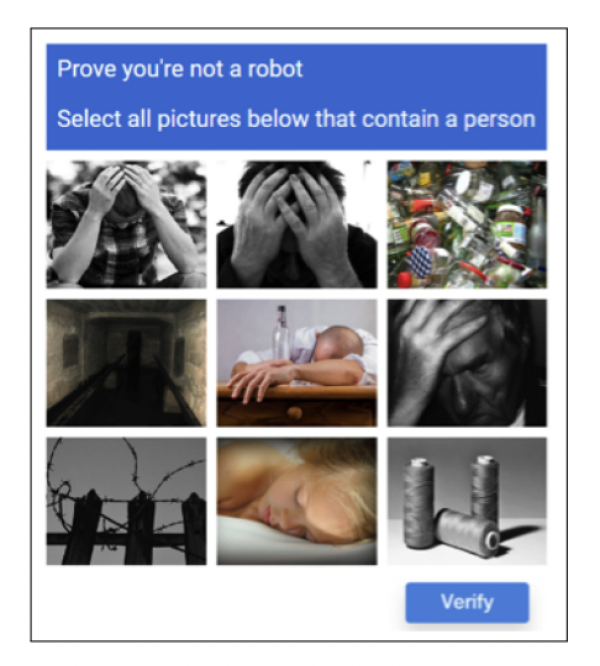

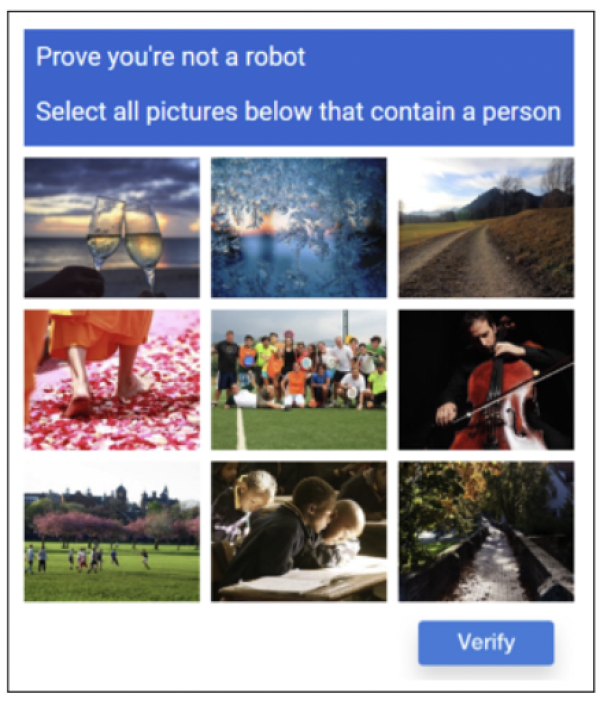

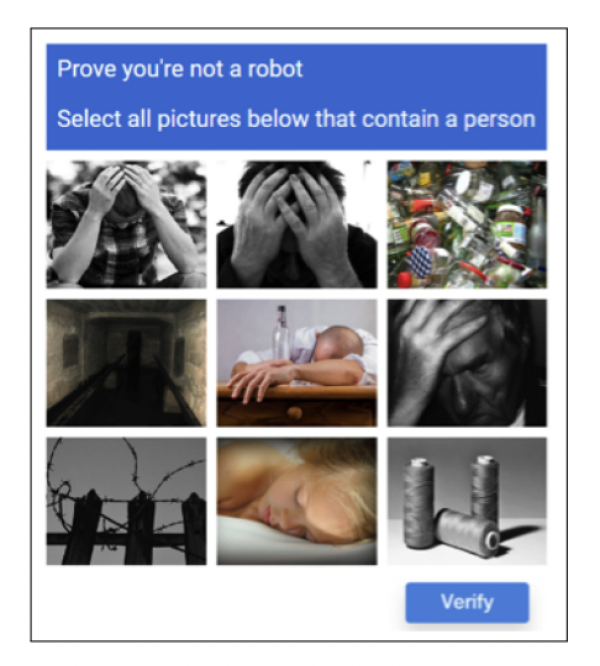

為了研究如何使社交媒體上的用戶們相對文明地討論極具爭議性的政治議題,他和合作者們設(shè)計出了一系列不按常理出牌的驗證碼(Captcha)。跟普通的驗證碼(譬如,請找出下列帶有汽車的圖片)不同,斯蒂爾們設(shè)計的驗證碼們含有隱藏的心理學暗示,分為“積極”和“消極”兩類。譬如,同樣是請找出下列圖片里帶有人的那一組,“積極”的驗證碼里顯示的圖片大多是趨向樂觀平靜的(比如足球賽和音樂會),“消極”的驗證碼顯示的圖片卻大多是令人不安的(比如醉酒者或是抑郁者)。

為了更好地測試不同類型的驗證碼對社交媒體用戶發(fā)言的影響,在斯蒂爾的實驗里,用戶在發(fā)帖前,會被隨機地分為兩組,只有通過所屬類別的驗證碼之后才能發(fā)帖。

圖為斯蒂爾實驗里設(shè)計的兩組驗證碼:上圖是“積極的”;下圖是“消極的”。來源:Seering, J., Fang, T., Damasco, L., Chen, M. C., Sun, L., & Kaufman, G. (2019, May). Designing user interface elements to improve the quality and civility of discourse in online commenting behaviors. In Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems (pp. 1-14)

斯蒂爾的論文證明了,積極的驗證碼的確對用戶的發(fā)言質(zhì)量有顯著的影響:在發(fā)帖前看到積極平靜圖片的用戶,他的帖子會不自覺地更為積極正面,論述會更為復(fù)雜,也會顯示更多的社會聯(lián)系。

在斯坦福大學人機交互組做了兩年博士后研究之后,斯蒂爾即將加入素有“韓國清華”之稱的KAIST(The Korea Advanced Institute of Science and Technology)擔任計算機系助理教授。回顧這篇發(fā)表于2019年人機交互領(lǐng)域頂級會議CHI的論文,斯蒂爾說,這篇論文其實在評審過程中引發(fā)了極大的爭議。當時的同行評審專家們對論文的發(fā)現(xiàn)很感興趣,卻對論文的設(shè)計有著倫理上的質(zhì)疑。最大的爭議圍繞著所謂的“說服式設(shè)計”(Persuasive Design??): 一種利用心理學理論來設(shè)計產(chǎn)品,使之以人類不自知的方式影響人類行為的設(shè)計。

同行評審專家們說,這篇論文里的驗證碼,就是這樣一種“說服式設(shè)計”。用戶在不自知的情況下點開或積極、或消極的驗證碼,結(jié)果卻被貌似“中立”的驗證碼們不知不覺地影響了自己在社交媒體上的發(fā)言。如果類似驗證碼的設(shè)計被惡意地使用在其他場景里呢?譬如,使用在大型社交媒體上,被用來影響民意,干預(yù)網(wǎng)民們在美國大選時的發(fā)言?

其后果甚至可以是災(zāi)難式的。

對受過心理學訓練的人來說,即使貴為靈長類之首,人類的行為模式事實上與動物相差不遠。人類的思維簡單粗暴,人類的行為是非常容易被預(yù)測和引導(dǎo)的。

譬如,之前我們討論過的大名鼎鼎的“福格模型”(BJ Foog's Behaviour Model),就立志于在動機、能力和觸發(fā)點這三個基本元素里尋找平衡。因為任何一個人類行為的發(fā)生,都需要滿足以上三大基本元素:人們需要有產(chǎn)生行為的動機、要有實行行為的能力,以及正好有一個合適的觸發(fā)點。

又比如,我們之前討論過的 “損失厭惡”(Loss Aversion) ,是指在面對同樣數(shù)量的收益和損失時,人類會主觀地認為損失比收益更加令他們難以忍受。譬如,與其告訴員工們 “在繁忙的周五晚上工作會將你的收入提高25%”,還不如簡單地更換一下語言的組織方式,告訴他們:“如果你不在周五晚上工作,你會比那些在周五晚上工作的少賺25%”。即使是一樣的25%,告訴員工們“少賺”往往比“多賺”更能使他們憤懣難當。

再比如,人類還有非常嚴重的“確認偏差” (Confirmation Bias)。當我們確認一個觀點之后,就會去竭盡全力地尋找證據(jù)來支持我們已經(jīng)相信的觀點,哪怕這一觀點本身缺乏足夠證據(jù)。我們會把模糊論據(jù)、疑似證據(jù),不靠譜的消息、乃至假消息當成支持自己這一派的理由。有些時候,我們甚至會選擇性忽略對自己觀點不利的證據(jù)——不管那些證據(jù)是如何雄辯有力。

在社交媒體的進化史上,利用心理學原理進行設(shè)計的例子更是比比皆是,且大多以資本的利益為導(dǎo)向,以民眾的智識為犧牲。今年五月,美國著名的社會心理學家、紐約大學商學院的教授喬納森·海特(Jonathan Haidt)在《大西洋月刊》(The Atlantic)上發(fā)表了轟動一時的長文 “為什么過去十年美國人的生活尤其愚蠢”(Why The Past 10 Years Of American Life Have Been Uniquely Stupid),追溯了過去十年里社交媒體的進化史,及其對美國公眾的負面影響。

在海特看來,2009-2011年左右的社交媒體,經(jīng)歷了從“善”到“惡”的分水嶺式轉(zhuǎn)變。其中一個很重要的標志,就是臉書采用了全新的設(shè)計,更改了在用戶的主頁上內(nèi)容顯示的排序方式:從按“時間”排序變成了按“喜好”排序。

2009年之前,以臉書為代表的新一代社交媒體,使用的都是“按時間先后排序”——你在主頁上看到的內(nèi)容(好友最新的動態(tài),關(guān)注人的發(fā)帖)基本都按照一個非常簡單的先后順序排列,最新的帖子排在最前面。2009年,臉書給所有的帖子增加了“贊” (Like)的按鈕,推特則進一步,增加了“轉(zhuǎn)發(fā)”(Retweet)的功能。臉書迅速跟進,在“贊”的基礎(chǔ)上,增加了“分享”(Share)的功能。

這些小小按鈕的增加,賦予了社交媒體在某種程度上體察用戶心理的超能力。臉書首當其沖地發(fā)現(xiàn)了“點贊”按鈕產(chǎn)生的數(shù)據(jù),經(jīng)由算法的處理,能準確地預(yù)測哪些內(nèi)容更容易迎合用戶喜好,增加用戶與平臺互動的頻率,從而把用戶盡可能長時間地留在平臺上。很快,以臉書為代表的新一代社交媒體全體轉(zhuǎn)向,幾乎毫無例外地一致采用了按用戶的喜好——以“點贊”“分享”“轉(zhuǎn)發(fā)”為基準進行量化 —— 排列主頁內(nèi)容的方式。

站在2009-2011年轉(zhuǎn)向之初的社交媒體用戶們,起先并沒有發(fā)現(xiàn)更改內(nèi)容排序設(shè)計的威力。

臉書用戶們最開始的困惑是,有些之前經(jīng)常發(fā)帖的朋友,莫名其妙地從他們的主頁上消失了。他們以為,也許是朋友把他屏蔽了——“我再未見過她貼任何東西! 我一直以為我和那個人并不是那么親近”。

緊接著,研究者們的大規(guī)模實驗開始發(fā)現(xiàn),什么樣的帖子最容易收到用戶的“點贊”“分享”“轉(zhuǎn)發(fā)”呢?那些能夠引發(fā)用戶情感層面上的反應(yīng)的,尤其是,能夠引發(fā)對自己群體以外的那批人的憤怒的。這意味著,短平快、情緒激烈、容易激起憤怒的帖子在算法排序的時代里更占優(yōu)勢。長文,不引發(fā)情緒反應(yīng)的、平緩的說理文,會逐漸從用戶的主頁被算法默默抹去。在美國的語境下,也同時意味著社交媒體上,保守派和自由派之間的裂痕由此日漸加大。

更為嚴重的是,各大自媒體運營商在接入體量日漸龐大的社交平臺之后,也在自覺或不自覺地按照這一平臺制定的規(guī)則行事。如果能把用戶的“點贊”“分享”“轉(zhuǎn)發(fā)”應(yīng)用好,也就是,如果能有效地利用人類容易被情緒和憤怒左右的天性,你的帖子會更容易“火”,更容易被算法推薦,被更多人閱讀和打賞,也就更容易轉(zhuǎn)化為直接可觀的利益收入。

當然,最可怕的是,這個看似簡單的排序方式的更改,在不自覺地影響著人類在社交媒體上的行為。也就是說,一開始按人類喜好訓練的排序算法,在日復(fù)一日的排序過程中和人類用戶進一步互動,也在不知不覺中重新塑造著人類用戶的喜好:你喜歡憤怒的帖子,我給你更多憤怒的帖子,直到憤怒的程度被重新定義。

2021年,耶魯大學的心理學家威廉·布雷迪(William Brady)的團隊使用計算機軟件收集并分析了來自7331名推特用戶圍繞一系列政治上極具爭議的話題發(fā)表的1270萬條推文。論文發(fā)現(xiàn):“社交媒體的激勵機制正在改變我們在線政治對話的基調(diào)……一些人甚至隨著時間的推移學會了表達更多的憤怒,因為他們得到了社交媒體算法的正向反饋。”

在機器學習里,這種算法范式被廣泛運用于各大社交媒體平臺,在與大規(guī)模人類用戶的互動里發(fā)揚光大,有個非常反諷的名字,叫做“強化學習”(Reinforcement Learning)。

海特在他那篇引發(fā)巨大反響的雄文里反思到,社交媒體的這些貌似微不足道的設(shè)計在過去的十年里重塑了美國人的生活,“我們迷失了方向,無法說同樣的語言,也無法認識同樣的真理。我們不僅彼此隔絕,也與過去隔絕。” (We are disoriented, unable to speak the same language or recognize the same truth. We are cut off from one another and from the past.)

經(jīng)過激烈的辯論,斯蒂爾那篇論文得以面世。在論文的最后,斯蒂爾和作者們對他們設(shè)計的驗證碼和備受爭議的“說服性設(shè)計”提出了三個反思性問題:

“首先,我們必須考慮哪些形式的‘說服性設(shè)計’、在何種場景下、是可以接受的?這意味著在商業(yè)場景下、政治場景下、健康場景下會有不同的考量。

其次,我們必須考慮披露問題。在道德上什么程度的披露是必要的?是否應(yīng)該在法律層面上要求使用說服性設(shè)計的組織披露他們正在使用說服性設(shè)計?是否應(yīng)該要求他們具體披露他們是如何使用的?

最后,是否應(yīng)該使用說服性設(shè)計?我們認為,最后一個問題已經(jīng)有了答案;說服性設(shè)計實際上已然是當代所有(人機交互)設(shè)計的核心,無法與之分割。說我們不使用說服性設(shè)計,相當于說我們對于一種設(shè)計是如何影響人類行為一無所知。”

參考文獻:

1. Seering, J., Fang, T., Damasco, L., Chen, M. C., Sun, L., & Kaufman, G. (2019, May). Designing user interface elements to improve the quality and civility of discourse in online commenting behaviors. In Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems (pp. 1-14).

2. Haidt, J. (2022). Why the Past 10 Years of American Life Have Been Uniquely Stupid. The Atlantic, 11.

3. Eslami, M., Rickman, A., Vaccaro, K., Aleyasen, A., Vuong, A., Karahalios, K., ... & Sandvig, C. (2015, April). " I always assumed that I wasn't really that close to [her]" Reasoning about Invisible Algorithms in News Feeds. In Proceedings of the 33rd annual ACM conference on human factors in computing systems (pp. 153-162).

4. Brady, W. J., Wills, J. A., Jost, J. T., Tucker, J. A., & Van Bavel, J. J. (2017). Emotion shapes the diffusion of moralized content in social networks. Proceedings of the National Academy of Sciences, 114(28), 7313-7318.

5. Rathje, S., Van Bavel, J. J., & Van Der Linden, S. (2021). Out-group animosity drives engagement on social media. Proceedings of the National Academy of Sciences, 118(26).

6. Brady, W. J., McLoughlin, K., Doan, T. N., & Crockett, M. J. (2021). How social learning amplifies moral outrage expression in online social networks. Science Advances, 7(33).

-----

作者沈虹,畢業(yè)于美國伊利諾伊大學香檳分校傳播學系,現(xiàn)任職于美國卡內(nèi)基梅隆大學。她用社會學的方法研究新興科技。

責任編輯:單雪菱校對:欒夢澎湃新聞報料:021-962866澎湃新聞,未經(jīng)授權(quán)不得轉(zhuǎn)載+1收藏我要舉報

不久前,我系畢業(yè)的博士生約瑟夫·斯蒂爾(Joseph Steering)做了一個超級可愛的論文。

為了研究如何使社交媒體上的用戶們相對文明地討論極具爭議性的政治議題,他和合作者們設(shè)計出了一系列不按常理出牌的驗證碼(Captcha)。跟普通的驗證碼(譬如,請找出下列帶有汽車的圖片)不同,斯蒂爾們設(shè)計的驗證碼們含有隱藏的心理學暗示,分為“積極”和“消極”兩類。譬如,同樣是請找出下列圖片里帶有人的那一組,“積極”的驗證碼里顯示的圖片大多是趨向樂觀平靜的(比如足球賽和音樂會),“消極”的驗證碼顯示的圖片卻大多是令人不安的(比如醉酒者或是抑郁者)。

為了更好地測試不同類型的驗證碼對社交媒體用戶發(fā)言的影響,在斯蒂爾的實驗里,用戶在發(fā)帖前,會被隨機地分為兩組,只有通過所屬類別的驗證碼之后才能發(fā)帖。

圖為斯蒂爾實驗里設(shè)計的兩組驗證碼:上圖是“積極的”;下圖是“消極的”。來源:Seering, J., Fang, T., Damasco, L., Chen, M. C., Sun, L., & Kaufman, G. (2019, May). Designing user interface elements to improve the quality and civility of discourse in online commenting behaviors. In Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems (pp. 1-14)

斯蒂爾的論文證明了,積極的驗證碼的確對用戶的發(fā)言質(zhì)量有顯著的影響:在發(fā)帖前看到積極平靜圖片的用戶,他的帖子會不自覺地更為積極正面,論述會更為復(fù)雜,也會顯示更多的社會聯(lián)系。

在斯坦福大學人機交互組做了兩年博士后研究之后,斯蒂爾即將加入素有“韓國清華”之稱的KAIST(The Korea Advanced Institute of Science and Technology)擔任計算機系助理教授。回顧這篇發(fā)表于2019年人機交互領(lǐng)域頂級會議CHI的論文,斯蒂爾說,這篇論文其實在評審過程中引發(fā)了極大的爭議。當時的同行評審專家們對論文的發(fā)現(xiàn)很感興趣,卻對論文的設(shè)計有著倫理上的質(zhì)疑。最大的爭議圍繞著所謂的“說服式設(shè)計”(Persuasive Design??): 一種利用心理學理論來設(shè)計產(chǎn)品,使之以人類不自知的方式影響人類行為的設(shè)計。

同行評審專家們說,這篇論文里的驗證碼,就是這樣一種“說服式設(shè)計”。用戶在不自知的情況下點開或積極、或消極的驗證碼,結(jié)果卻被貌似“中立”的驗證碼們不知不覺地影響了自己在社交媒體上的發(fā)言。如果類似驗證碼的設(shè)計被惡意地使用在其他場景里呢?譬如,使用在大型社交媒體上,被用來影響民意,干預(yù)網(wǎng)民們在美國大選時的發(fā)言?

其后果甚至可以是災(zāi)難式的。

對受過心理學訓練的人來說,即使貴為靈長類之首,人類的行為模式事實上與動物相差不遠。人類的思維簡單粗暴,人類的行為是非常容易被預(yù)測和引導(dǎo)的。

譬如,之前我們討論過的大名鼎鼎的“福格模型”(BJ Foog's Behaviour Model),就立志于在動機、能力和觸發(fā)點這三個基本元素里尋找平衡。因為任何一個人類行為的發(fā)生,都需要滿足以上三大基本元素:人們需要有產(chǎn)生行為的動機、要有實行行為的能力,以及正好有一個合適的觸發(fā)點。

又比如,我們之前討論過的 “損失厭惡”(Loss Aversion) ,是指在面對同樣數(shù)量的收益和損失時,人類會主觀地認為損失比收益更加令他們難以忍受。譬如,與其告訴員工們 “在繁忙的周五晚上工作會將你的收入提高25%”,還不如簡單地更換一下語言的組織方式,告訴他們:“如果你不在周五晚上工作,你會比那些在周五晚上工作的少賺25%”。即使是一樣的25%,告訴員工們“少賺”往往比“多賺”更能使他們憤懣難當。

再比如,人類還有非常嚴重的“確認偏差” (Confirmation Bias)。當我們確認一個觀點之后,就會去竭盡全力地尋找證據(jù)來支持我們已經(jīng)相信的觀點,哪怕這一觀點本身缺乏足夠證據(jù)。我們會把模糊論據(jù)、疑似證據(jù),不靠譜的消息、乃至假消息當成支持自己這一派的理由。有些時候,我們甚至會選擇性忽略對自己觀點不利的證據(jù)——不管那些證據(jù)是如何雄辯有力。

在社交媒體的進化史上,利用心理學原理進行設(shè)計的例子更是比比皆是,且大多以資本的利益為導(dǎo)向,以民眾的智識為犧牲。今年五月,美國著名的社會心理學家、紐約大學商學院的教授喬納森·海特(Jonathan Haidt)在《大西洋月刊》(The Atlantic)上發(fā)表了轟動一時的長文 “為什么過去十年美國人的生活尤其愚蠢”(Why The Past 10 Years Of American Life Have Been Uniquely Stupid),追溯了過去十年里社交媒體的進化史,及其對美國公眾的負面影響。

在海特看來,2009-2011年左右的社交媒體,經(jīng)歷了從“善”到“惡”的分水嶺式轉(zhuǎn)變。其中一個很重要的標志,就是臉書采用了全新的設(shè)計,更改了在用戶的主頁上內(nèi)容顯示的排序方式:從按“時間”排序變成了按“喜好”排序。

2009年之前,以臉書為代表的新一代社交媒體,使用的都是“按時間先后排序”——你在主頁上看到的內(nèi)容(好友最新的動態(tài),關(guān)注人的發(fā)帖)基本都按照一個非常簡單的先后順序排列,最新的帖子排在最前面。2009年,臉書給所有的帖子增加了“贊” (Like)的按鈕,推特則進一步,增加了“轉(zhuǎn)發(fā)”(Retweet)的功能。臉書迅速跟進,在“贊”的基礎(chǔ)上,增加了“分享”(Share)的功能。

這些小小按鈕的增加,賦予了社交媒體在某種程度上體察用戶心理的超能力。臉書首當其沖地發(fā)現(xiàn)了“點贊”按鈕產(chǎn)生的數(shù)據(jù),經(jīng)由算法的處理,能準確地預(yù)測哪些內(nèi)容更容易迎合用戶喜好,增加用戶與平臺互動的頻率,從而把用戶盡可能長時間地留在平臺上。很快,以臉書為代表的新一代社交媒體全體轉(zhuǎn)向,幾乎毫無例外地一致采用了按用戶的喜好——以“點贊”“分享”“轉(zhuǎn)發(fā)”為基準進行量化 —— 排列主頁內(nèi)容的方式。

站在2009-2011年轉(zhuǎn)向之初的社交媒體用戶們,起先并沒有發(fā)現(xiàn)更改內(nèi)容排序設(shè)計的威力。

臉書用戶們最開始的困惑是,有些之前經(jīng)常發(fā)帖的朋友,莫名其妙地從他們的主頁上消失了。他們以為,也許是朋友把他屏蔽了——“我再未見過她貼任何東西! 我一直以為我和那個人并不是那么親近”。

緊接著,研究者們的大規(guī)模實驗開始發(fā)現(xiàn),什么樣的帖子最容易收到用戶的“點贊”“分享”“轉(zhuǎn)發(fā)”呢?那些能夠引發(fā)用戶情感層面上的反應(yīng)的,尤其是,能夠引發(fā)對自己群體以外的那批人的憤怒的。這意味著,短平快、情緒激烈、容易激起憤怒的帖子在算法排序的時代里更占優(yōu)勢。長文,不引發(fā)情緒反應(yīng)的、平緩的說理文,會逐漸從用戶的主頁被算法默默抹去。在美國的語境下,也同時意味著社交媒體上,保守派和自由派之間的裂痕由此日漸加大。

更為嚴重的是,各大自媒體運營商在接入體量日漸龐大的社交平臺之后,也在自覺或不自覺地按照這一平臺制定的規(guī)則行事。如果能把用戶的“點贊”“分享”“轉(zhuǎn)發(fā)”應(yīng)用好,也就是,如果能有效地利用人類容易被情緒和憤怒左右的天性,你的帖子會更容易“火”,更容易被算法推薦,被更多人閱讀和打賞,也就更容易轉(zhuǎn)化為直接可觀的利益收入。

當然,最可怕的是,這個看似簡單的排序方式的更改,在不自覺地影響著人類在社交媒體上的行為。也就是說,一開始按人類喜好訓練的排序算法,在日復(fù)一日的排序過程中和人類用戶進一步互動,也在不知不覺中重新塑造著人類用戶的喜好:你喜歡憤怒的帖子,我給你更多憤怒的帖子,直到憤怒的程度被重新定義。

2021年,耶魯大學的心理學家威廉·布雷迪(William Brady)的團隊使用計算機軟件收集并分析了來自7331名推特用戶圍繞一系列政治上極具爭議的話題發(fā)表的1270萬條推文。論文發(fā)現(xiàn):“社交媒體的激勵機制正在改變我們在線政治對話的基調(diào)……一些人甚至隨著時間的推移學會了表達更多的憤怒,因為他們得到了社交媒體算法的正向反饋。”

在機器學習里,這種算法范式被廣泛運用于各大社交媒體平臺,在與大規(guī)模人類用戶的互動里發(fā)揚光大,有個非常反諷的名字,叫做“強化學習”(Reinforcement Learning)。

海特在他那篇引發(fā)巨大反響的雄文里反思到,社交媒體的這些貌似微不足道的設(shè)計在過去的十年里重塑了美國人的生活,“我們迷失了方向,無法說同樣的語言,也無法認識同樣的真理。我們不僅彼此隔絕,也與過去隔絕。” (We are disoriented, unable to speak the same language or recognize the same truth. We are cut off from one another and from the past.)

經(jīng)過激烈的辯論,斯蒂爾那篇論文得以面世。在論文的最后,斯蒂爾和作者們對他們設(shè)計的驗證碼和備受爭議的“說服性設(shè)計”提出了三個反思性問題:

“首先,我們必須考慮哪些形式的‘說服性設(shè)計’、在何種場景下、是可以接受的?這意味著在商業(yè)場景下、政治場景下、健康場景下會有不同的考量。

其次,我們必須考慮披露問題。在道德上什么程度的披露是必要的?是否應(yīng)該在法律層面上要求使用說服性設(shè)計的組織披露他們正在使用說服性設(shè)計?是否應(yīng)該要求他們具體披露他們是如何使用的?

最后,是否應(yīng)該使用說服性設(shè)計?我們認為,最后一個問題已經(jīng)有了答案;說服性設(shè)計實際上已然是當代所有(人機交互)設(shè)計的核心,無法與之分割。說我們不使用說服性設(shè)計,相當于說我們對于一種設(shè)計是如何影響人類行為一無所知。”

參考文獻:

1. Seering, J., Fang, T., Damasco, L., Chen, M. C., Sun, L., & Kaufman, G. (2019, May). Designing user interface elements to improve the quality and civility of discourse in online commenting behaviors. In Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems (pp. 1-14).

2. Haidt, J. (2022). Why the Past 10 Years of American Life Have Been Uniquely Stupid. The Atlantic, 11.

3. Eslami, M., Rickman, A., Vaccaro, K., Aleyasen, A., Vuong, A., Karahalios, K., ... & Sandvig, C. (2015, April). " I always assumed that I wasn't really that close to [her]" Reasoning about Invisible Algorithms in News Feeds. In Proceedings of the 33rd annual ACM conference on human factors in computing systems (pp. 153-162).

4. Brady, W. J., Wills, J. A., Jost, J. T., Tucker, J. A., & Van Bavel, J. J. (2017). Emotion shapes the diffusion of moralized content in social networks. Proceedings of the National Academy of Sciences, 114(28), 7313-7318.

5. Rathje, S., Van Bavel, J. J., & Van Der Linden, S. (2021). Out-group animosity drives engagement on social media. Proceedings of the National Academy of Sciences, 118(26).

6. Brady, W. J., McLoughlin, K., Doan, T. N., & Crockett, M. J. (2021). How social learning amplifies moral outrage expression in online social networks. Science Advances, 7(33).

-----

作者沈虹,畢業(yè)于美國伊利諾伊大學香檳分校傳播學系,現(xiàn)任職于美國卡內(nèi)基梅隆大學。她用社會學的方法研究新興科技。

- 報料熱線: 021-962866

- 報料郵箱: news@thepaper.cn

互聯(lián)網(wǎng)新聞信息服務(wù)許可證:31120170006

增值電信業(yè)務(wù)經(jīng)營許可證:滬B2-2017116

? 2014-2025 上海東方報業(yè)有限公司