- +1

算法相對論|馬庫斯對賭馬斯克:深度學(xué)習(xí)撞墻了,楊立昆有話說

一面是“深度學(xué)習(xí)(DL, Deep Learning)撞墻了”的呼喊,一面是馬上就能造出類人AI的喜悅。“深度學(xué)習(xí)三巨頭”之一的Yann LeCun(楊立昆)終于坐不住了。

當(dāng)?shù)貢r間6月16日,Yann LeCun撰文《關(guān)于智能,AI能告訴我們什么》首次正面回應(yīng)深度學(xué)習(xí)當(dāng)下面臨的問題。LeCun寫道,“從一開始,批評者就過早地認(rèn)為神經(jīng)網(wǎng)絡(luò)已經(jīng)遇到了不可翻越的墻,但每次都被證明只是一個暫時的障礙。”

LeCun認(rèn)為,這是一場關(guān)于深度學(xué)習(xí)前景的辯論。辯論的核心是對符號在智能中的作用存在兩種不同的看法:一種認(rèn)為符號推理必須從一開始就被硬編碼,另一種認(rèn)為機器可以像人類一樣從經(jīng)驗中學(xué)習(xí)。這涉及到我們應(yīng)該如何理解人類智能,進而去追求人類水平的人工智能。

對賭世界首富馬斯克,五十萬美元獎金池已備好

2012年,Geoffrey Hinton帶領(lǐng)的團隊一鳴驚人奪得ImageNET大規(guī)模視覺識別挑戰(zhàn)賽(ILSVRC)冠軍。此后,深度學(xué)習(xí)成為人工智能研究的主要焦點。

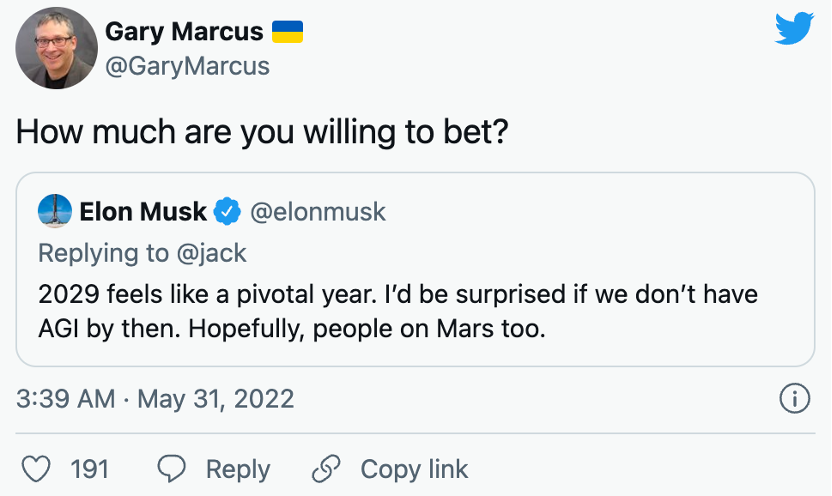

深度學(xué)習(xí)已經(jīng)在曾經(jīng)對計算機非常具有挑戰(zhàn)性的很多任務(wù)上取得了進展,包括圖像分類、對象檢測、語音識別和自然語言處理。它的表現(xiàn)甚至讓人覺得造出類人的智能體也指日可待,埃隆·馬斯克在推特放言,“2029年感覺是關(guān)鍵一年。如果那時我們還沒有AGI(通用人工智能),我會感到驚訝。希望火星上的人也一樣。”

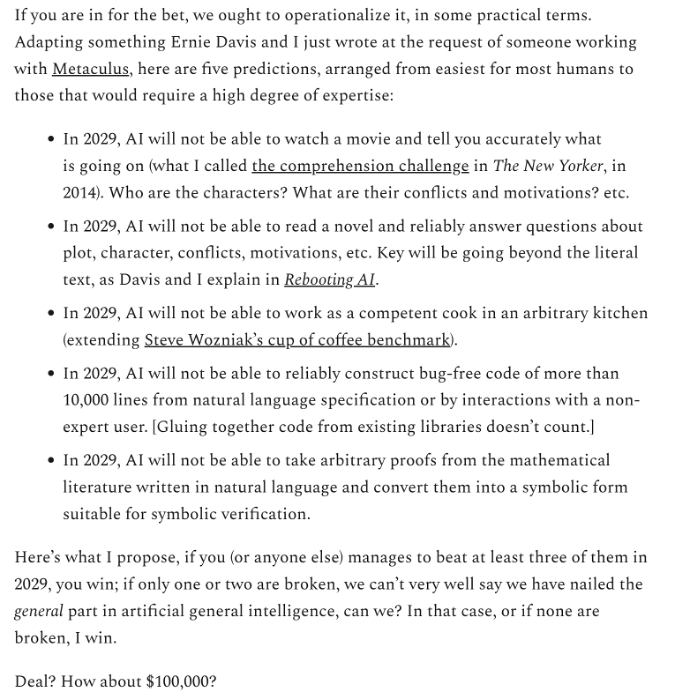

馬斯克的言論在AI社區(qū)中激起眾多反對聲音,知名AI科學(xué)家、紐約大學(xué)教授加里·馬庫斯(Gary Marcus)提出與馬斯克對賭10萬美元。馬庫斯與紐約大學(xué)計算機科學(xué)家Ernest Davis合作編制以下五個檢驗AGI是否實現(xiàn)的標(biāo)準(zhǔn),作為打賭的內(nèi)容:

2029年,AI無法看懂電影然后準(zhǔn)確告訴你正在發(fā)生的事情(人物是誰、他們的沖突和動機是什么等);

2029年,AI無法閱讀小說并可靠地回答有關(guān)情節(jié)、人物、沖突、動機等的問題;

2029年,AI無法在任何廚房中擔(dān)任稱職的廚師;

2029年,AI無法通過自然語言規(guī)范或與非專家用戶的交互可靠地構(gòu)建超過10000行的無錯誤代碼(將現(xiàn)有庫中的代碼粘合在一起不算數(shù));

2029年,AI無法從以自然語言編寫的數(shù)學(xué)文獻中任意取證,并將其轉(zhuǎn)換為適合符號驗證的符號形式。

“這是我的建議,如果你(或任何其他人)在2029年設(shè)法完成至少三個,就算你贏了。十萬美元如何?”馬庫斯寫道。

馬庫斯發(fā)出這條推特幾個小時之內(nèi),發(fā)布賭局的網(wǎng)站瀏覽量就接近1萬次,獎金池目前已增加到50萬美元,由作家凱文·凱利(Kevin Kelly)提出在他的網(wǎng)站上進行托管。但馬斯克再無回應(yīng)。

馬庫斯對馬斯克說道,“比如你在2015年說過,實現(xiàn)完全自動駕駛的汽車還需要兩年時間,從那以后,你幾乎每年都說一遍同樣的話,可現(xiàn)在完全自動駕駛?cè)晕磳崿F(xiàn)。”

馬庫斯一直對深度學(xué)習(xí)的技術(shù)路徑有所懷疑,他曾寫了一本關(guān)于深度學(xué)習(xí)的限制的書,他支持將不同AI技術(shù)結(jié)合在一起的混合方法。3月中旬,馬庫斯曾經(jīng)撰文《深度學(xué)習(xí)撞墻了》,認(rèn)為純粹端到端的深度學(xué)習(xí)快走到盡頭,整個AI領(lǐng)域必須另尋出路。

混合方法VS純深度學(xué)習(xí):馬庫斯嗆聲Hinton

終于,6月1日,一向深居簡出的Geoffrey Hinton在加州伯克利教授Pieter Abbeel的播客節(jié)目中談到了這個話題,“如果有人說(深度學(xué)習(xí))撞墻了,那么他們只需列出一張清單,列出深度學(xué)習(xí)無法做到的事情。5年后,我們就能證明深度學(xué)習(xí)做到了。”

于是,馬庫斯在推特上寫了一封給Geoffrey Hinton的公開信,又提到了他與Ernest Davis合作編制的五條判斷AGI的標(biāo)準(zhǔn),意思是其已經(jīng)在與馬斯克的賭局里把深度學(xué)習(xí)不能做的事列出來了。

深度學(xué)習(xí)的缺點確實隨著發(fā)展日益清晰,包括其有限的泛化性、與因果關(guān)系的斗爭和缺乏可解釋性。此外,大多數(shù)深度學(xué)習(xí)應(yīng)用程序需要大量手動注釋的訓(xùn)練示例,這也成了瓶頸。但在三位以其對深度學(xué)習(xí)的開創(chuàng)性貢獻而聞名的圖靈獎得主Geoffrey Hinton、Yoshua Bengio和Yann LeCun看來,更好的神經(jīng)網(wǎng)絡(luò)架構(gòu)最終將克服深度學(xué)習(xí)的當(dāng)前限制。

LeCun在文章中寫道,“今天看似不可逾越的墻是符號推理,即以代數(shù)或邏輯的方式操縱符號的能力。我們知道,解決數(shù)學(xué)問題需要根據(jù)嚴(yán)格的規(guī)則逐步處理符號。作為《The Algebraic Mind》的作者和《Rebooting AI》的作者之一,Gary Marcus最近聲稱深度學(xué)習(xí)無法進一步取得進展,因為神經(jīng)網(wǎng)絡(luò)在處理符號操作方面存在困難。然而,許多深度學(xué)習(xí)研究人員確信深度學(xué)習(xí)已經(jīng)在進行符號推理并將持續(xù)改進。”

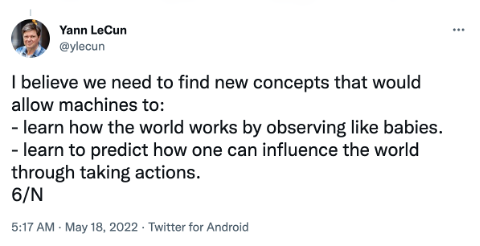

其實,LeCun在5月份也發(fā)推文表示,“我相信我們需要找到新的概念,讓機器能夠:通過像嬰兒一樣觀察來了解世界是如何運作的。學(xué)會預(yù)測一個人如何通過采取行動來影響世界。”但這里說的跟馬庫斯倡導(dǎo)的不是同一回事,LeCun正在研究的是一種更復(fù)雜的自我監(jiān)督學(xué)習(xí),馬庫斯則支持混合方法。

最近獲得關(guān)注的一種混合方法是神經(jīng)符號人工智能,這是人工智能的一個分支,曾隨著深度學(xué)習(xí)的興起而被淘汰。它將人工神經(jīng)網(wǎng)絡(luò)與符號系統(tǒng)相結(jié)合,但將人類專業(yè)知識提煉成一套規(guī)則,事實證明是非常困難、耗時且昂貴的,這也被稱為“知識獲取瓶頸”。雖然為數(shù)學(xué)或邏輯編寫規(guī)則很簡單,但世界本身卻非常模棱兩可,事實證明,不可能為每個模式編寫規(guī)則或為模糊概念定義符號。

在3月IBM神經(jīng)符號AI研討會上的一次演講中,麻省理工學(xué)院計算認(rèn)知科學(xué)教授Joshua Tenenbaum(約書亞·特南鮑姆)解釋了當(dāng)前神經(jīng)符號系統(tǒng)如何幫助解決AI系統(tǒng)的一些關(guān)鍵問題,包括缺乏常識和因果關(guān)系、組合性和直覺物理學(xué)。

“我們?nèi)绾纬街悄艿母拍睿醋R別數(shù)據(jù)中的模式和近似函數(shù),更多地走向人類思維對世界的建模——解釋和理解你所看到的事物,想象你看不到但可能發(fā)生的事情,并將它們變成你可以通過計劃行動和解決問題來實現(xiàn)的目標(biāo)?”特南鮑姆認(rèn)為,要彌合與人類智能之間的差距,首先要探索的就是人類和許多動物共有的智力的基本方面之一:直覺物理學(xué)和心理學(xué)。

特南鮑姆的神經(jīng)符號AI概念中的一個關(guān)鍵組成部分是一個物理模擬器,將其集成到智能體的推理過程中,幫助AI實時模擬世界并預(yù)測未來會發(fā)生什么。

由此可以大致理解當(dāng)下的神經(jīng)符號系統(tǒng)AI思路。同時,這種方式也被證明比純深度學(xué)習(xí)系統(tǒng)需要更少的數(shù)據(jù)和計算資源。

這就引出了另一個問題——人工智能的范式轉(zhuǎn)變。馬庫斯又開了新的賭局,他認(rèn)為我們90%需要人工智能的范式轉(zhuǎn)變,而SlateStarCodex的名人Scott Alexander則認(rèn)為要低于60%。

LeCun提出爭論本質(zhì):智能如何運作?什么使人類獨特?

LeCun在文章中指出,馬庫斯對深度學(xué)習(xí)的批評源于認(rèn)知科學(xué)(以及在哲學(xué)中更古老)的一場相關(guān)斗爭,即智能如何產(chǎn)生以及什么使人類獨特。他的想法與心理學(xué)中一個著名的“先天理論”學(xué)派一致,該學(xué)派認(rèn)為認(rèn)知的許多關(guān)鍵特征是與生俱來的——實際上,我們在很大程度上天生就有一個關(guān)于世界如何運作的直觀模型。

這種與生俱來架構(gòu)的一個核心特征就是符號操縱的能力。但這是整個自然界中均有的還是人類特有的,尚存在爭議。對于馬庫斯來說,這種符號操縱能力是許多常識的基本特征的基礎(chǔ):遵循規(guī)則、抽象、因果推理、重新識別細(xì)節(jié)、概括等。簡而言之,我們對世界的大部分理解都是自然賦予的,而學(xué)習(xí)則是充實細(xì)節(jié)的過程。

另一種“經(jīng)驗主義”觀點則認(rèn)為:符號操縱在自然界中是罕見的,主要伴隨著人類祖先在過去兩百萬年中逐漸獲得的學(xué)習(xí)交流能力而產(chǎn)生的。根據(jù)這種觀點,認(rèn)知能力主要是與提高生存率相關(guān)的非符號學(xué)習(xí)能力,如快速識別獵物、預(yù)測它們的可能行為以及發(fā)展熟練的反應(yīng)。這個觀點假設(shè)絕大多數(shù)復(fù)雜的認(rèn)知能力是后天獲得的,是通過一種普遍的、自監(jiān)督的學(xué)習(xí)能力獲得。這是一種通過經(jīng)驗獲得直觀世界模型的能力,這個世界模型具備常識的核心特征。它還假設(shè),我們大多數(shù)復(fù)雜的認(rèn)知能力都不依賴于符號操縱,相反是通過模擬各種場景并預(yù)測最佳結(jié)果來做到這一點。

這種經(jīng)驗主義觀點將符號和符號操縱視為另一種學(xué)習(xí)能力,隨著人類越來越依賴合作行為取得成功就獲得了這種能力。這種觀點將符號視為人類用來協(xié)調(diào)合作活動的發(fā)明——如文字,地圖、標(biāo)志性描繪、儀式甚至社會角色。這些能力被認(rèn)為是由于越來越長的學(xué)習(xí)青春期和對更精確、更專業(yè)的技能(如工具制造和消防維修)需求的結(jié)合而產(chǎn)生的。這一觀點認(rèn)為符號和符號操作主要歸于文化發(fā)明,較少依賴于大腦中的硬接線(hard wiring),而更多地依賴于我們?nèi)找鎻?fù)雜的社會生活。

這兩種觀點之間的差異非常明顯。

對于先天論來說,符號和符號操縱本就在大腦之中,而文字和數(shù)字的使用正是從這種原始能力中衍生出來的。這種觀點很具吸引力地解釋了一系列源于進化適應(yīng)的能力(盡管對于符號操縱如何或為何進化的解釋一直存在爭議)。

對于經(jīng)驗主義者來說,符號和符號推理是用于交流目的的有用發(fā)明,它源于一般的學(xué)習(xí)能力和復(fù)雜的社會世界。這些內(nèi)部計算和內(nèi)心獨白等發(fā)生在我們頭腦中的象征性東西,因而被視為源自數(shù)學(xué)和語言使用的外部實踐。

人工智能和認(rèn)知科學(xué)領(lǐng)域密切相關(guān),因此這些爭論的重演也就不足為奇了。人工智能領(lǐng)域中任一觀點的成功,都會在部分程度上證明認(rèn)知科學(xué)中的一種或另一種方法是正確的(但也僅是部分程度上),因此這些爭論之激烈也就不足為奇了。現(xiàn)在面臨的問題不僅是關(guān)于人工智能當(dāng)代問題的正確方法,還有關(guān)于什么是智能以及大腦如何工作的問題。

如果馬庫斯和先天論者是對的,那么深度學(xué)習(xí)將永遠無法實現(xiàn)類人的AI,無論它提出了多少新架構(gòu)或投入了多少計算能力。不斷添加更多層只會令人困惑,因為真正的符號操縱需要一個與生俱來的符號操縱者。而且,由于這種符號操作是幾種常識能力的基礎(chǔ),因此深度學(xué)習(xí)系統(tǒng)將永遠不會擁有任何東西,只能擁有對事物粗略、現(xiàn)成的理解。

相比之下,如果深度學(xué)習(xí)的倡導(dǎo)者和經(jīng)驗主義者是正確的,那么插入符號操縱模塊的想法是令人困惑的。在這種情況下,深度學(xué)習(xí)系統(tǒng)已經(jīng)在進行符號推理,并將繼續(xù)改進它,因為它們通過更多的多模態(tài)自監(jiān)督學(xué)習(xí)、越來越有用的預(yù)測世界模型以及用于模擬的工作內(nèi)存的擴展以及評估結(jié)果來滿足約束。引入符號操縱模塊不會導(dǎo)致更像人類的AI,而是迫使所有“推理”通過一個不必要的瓶口,讓我們與類人智能漸行漸遠。這可能會切斷深度學(xué)習(xí)最令人印象深刻的方面之一:它能夠提出比人類程序員想象的更有用和更聰明的解決方案。

盡管賭注很高,但同樣重要的是,這些辯論中提出的許多問題至少在某種程度上是次要的。比如一些討論:深度學(xué)習(xí)系統(tǒng)中的高維向量應(yīng)該被視為離散符號(可能不是),實現(xiàn)深度學(xué)習(xí)系統(tǒng)所需的代碼行是否使其成為混合系統(tǒng)(語義),在復(fù)雜游戲中獲勝是否需要手工的、特定領(lǐng)域的知識,或者它是否可以學(xué)習(xí)(說得太早了)。還有一個問題是混合系統(tǒng)是否有助于解決圍繞人工智能的倫理問題(否)。

而這一切都不是為了證明這場愚蠢的炒作是合理的:當(dāng)前的系統(tǒng)沒有意識——它們并不能理解我們,強化學(xué)習(xí)還不夠,你不能僅僅通過擴大規(guī)模來建立類人智能。但所有這些問題都與主要爭論無關(guān):符號操縱是否需要硬編碼,還是可以學(xué)習(xí)?

這是停止研究混合模型的呼吁嗎?當(dāng)然不是。研究人員自1980年代以來一直在研究混合模型,但尚未證明它們是靈丹妙藥——或者在許多情況下,甚至遠不及神經(jīng)網(wǎng)絡(luò)。更廣泛地說,人們應(yīng)該懷疑深度學(xué)習(xí)是否已達到極限。

LeCun在結(jié)尾中寫道,鑒于最近DALL-E 2、Gato和PaLM中任務(wù)的持續(xù)、增量改進,避免將障礙誤認(rèn)為墻壁似乎是明智之舉。深度學(xué)習(xí)不可避免的失敗之前就已經(jīng)預(yù)料到了,但押注它是不值得的。

- 報料熱線: 021-962866

- 報料郵箱: news@thepaper.cn

互聯(lián)網(wǎng)新聞信息服務(wù)許可證:31120170006

增值電信業(yè)務(wù)經(jīng)營許可證:滬B2-2017116

? 2014-2025 上海東方報業(yè)有限公司